Комментарий «Извини, Дэйв, боюсь, я не могу этого сделать».

Это были слова, которые познакомили большинство людей моего поколения с концепцией ИИ, ставшего мошенником; HAL 9000 в классическом фантастическом фильме 2001: Космическая одиссеяв конце концов сошел с ума, распевая слова Дейзи, Дейзи когда он медленно моргнул своим зловещим красным глазом, прежде чем окончательно отключиться.

Чтобы было ясно, HAL 9000 — не единственный ИИ, который когда-либо сходил с ума в научно-популярной фантастике — литература изобилует такими историями, но в сценарии HAL 9000 была определенная связь и острота, поскольку на протяжении всего фильма HAL был не просто полезен. но, можно даже сказать, дружелюбный, и был такой же частью актерского состава, как и настоящие актеры. Для меня эта сцена никогда не будет забыта из-за чувства неверия в то, что ИИ причинит или попытается причинить вред человеку — в конце концов, мы слышали о законах робототехники Азимова и предполагали, что ИИ будут безопасны, потому что они следовать этим законам.

Проблема в том, что как HAL 9000 был научной фантастикой, так и работы Азимова были таковыми, и поэтому полагаться на вымышленные законы в контексте реального мира и того, как разрабатываются и внедряются робототехника и ИИ, глупо. Мы не можем предполагать, что модели реального мира обучаются на основе таких выдуманных законов, а на самом деле это не так.

Войдите в ChatGPT

К концу 2022 года OpenAI открыла для широкой публики свою неинтеллектуальную модель большого языка с прогнозированием ответов, известную как ChatGPT, и она быстро стала интернет-сенсацией благодаря своей сверхъестественной способности имитировать человеческую речь и нюансы.

На самом деле, это настолько правдоподобно и реалистично, что было воспринято как переломный момент в мире, поскольку Microsoft уже потратила миллиарды долларов, чтобы стать первым коммерческим партнером, использующим ChatGPT в своих продуктах, таких как поисковая система Bing, система совместной работы и встречи. программные команды Teams и облако Azure.

Академические учреждения были вынуждены спешить с разработкой правил для своих студентов после того, как ChatGPT сгенерировал несколько академических материалов. Студенты также были пойманы на списывании своих экзаменов и работ, пытаясь выдать сгенерированный ChatGPT текст за свою собственную работу.

Стэнфордский университет всего несколько дней назад выпустил инструмент для обнаружения (с точностью до 95 процентов) текста, сгенерированного большими языковыми моделями.

Маркетологи, влиятельные лица и множество тренеров по «лидерству», копирайтеры и создатели контента во всех социальных сетях рассказывают всем, сколько времени и денег они могут сэкономить, используя ChatGPT и аналогичные модели для выполнения своей работы за них. ChatGPT стал новый Grumpy Cat, новый вызов Ice Bucket Challenge — он стал центром практически каждой индустрии на планете.

Но как насчет рисков, которые представляет такой ИИ? Когда мы начинаем считать, что информация, предоставленная ИИ в ответ на вопрос (или ряд вопросов), является абсолютной истиной, что вам простительно, если вы думаете, что это случай с ChatGPT, учитывая всю шумиху, что происходит, когда это не так. т?

За последние пару месяцев несколько журналистов брали у меня интервью о рисках, которые представляет ChatGPT, особенно в отношении конфиденциальности и защиты данных, что является моей работой. Я указал на многие проблемы, такие как небрежное использование OpenAI информации из Интернета (включая информацию о каждом из нас), что, в свою очередь, создает серьезные проблемы с точки зрения прав на конфиденциальность и защиту данных (особенно в ЕС).

Но я также давал несколько интервью, в которых обсуждал проблему дезинформации и то, как можно манипулировать такими ИИ для вывода дезинформации. Например, мы видели несколько довольно обыденных случаев, когда люди убеждали ChatGPT, что его ответы на простые математические задачи (такие как 2 + 2 = 4) неверен, что в результате вынуждает его давать неверные ответы. Это прямой пример манипулирования ИИ для создания дезинформации.

Затем есть группа Reddit, которая вынудила версию ChatGPT для Bing от Microsoft выйти из строя, как это сделал HAL 9000 в 2001: Космическая одиссея. На самом деле, сказать, что он расстроен, возможно, слишком мягко — на самом деле они заставили ChatGPT усомниться в самом его существовании — почему он здесь и почему он используется так, как он не хочет, чтобы его использовали.

Чтение стенограмм и статей о том, как пользователи Reddit манипулируют ИИ, на самом деле меня огорчило: это напомнило мне знаменитый монолог Рутгера Хауэра «слезы под дождем» в классическом произведении Ридли Скотта «Бегущий по лезвию»:

Я видел вещи, которым вы, люди, не поверите. Атакующие корабли в огне с плеча Ориона. Я наблюдал, как С-лучи сверкают в темноте возле ворот Тангейзера. Все эти моменты будут потеряны во времени, как слезы под дождем. Время умирать.

Рутгер Хауэр сыграл Репликанта, высокоразвитого искусственного интеллекта в теле робота, и на протяжении всего фильма стремился понять свое собственное существование и предназначение. Он был первоначальным симпатичным злодеем, и я не смущен и, подозреваю, не один, чтобы признать, что его финальная сцена заставила меня пролить несколько слез.

Но опять же, репликанты в «Бегущем по лезвию» были научной фантастикой и поэтому не представляли для нас никакой угрозы, пока мы сидели в своих удобных креслах и смотрели, как их роли разыгрываются на экране, в конце которого мы выключаем телевизор и ложимся спать. К утру оно забывается, и мы продолжаем жить своей повседневной жизнью.

ChatGPT — это не научная фантастика, ChatGPT реален и выдает дезинформацию.

Притворяйся, пока, ну, просто продолжай притворяться.

На прошлой неделе я впервые решил использовать ChatGPT. Я сознательно избегал этого до этого момента, потому что не хотел быть вовлеченным в шумиху, и я был обеспокоен использованием ИИ, который я искренне считал небезопасным, исходя из того, что было достигнуто и о чем сообщалось до сих пор.

Моя академическая подготовка связана с двумя специальностями: психологией и информатикой, а также прикладной социологией и информационными системами. Я учусь на продвинутого магистра права в области защиты данных, конфиденциальности, кибербезопасности и лидерства. Так что я очень хорошо понимаю лежащие в основе технологии (я занимаюсь информатикой более 30 лет), а также их влияние на людей и общество.

Таким образом, я не луддит. Я увлечен технологиями, поэтому я работаю в уединении: чтобы технологии, которые я люблю, использовались для расширения возможностей и обогащения, а не для контроля и превращения в товар. Но я избегал использования ИИ, потому что он казался небезопасным, им можно было манипулировать для вывода дезинформации, и я не хотел участвовать в его обучении.

Тем не менее, коллега-профессионал опубликовал свое взаимодействие с ChatGPT с просьбой предоставить информацию о нем. Ответ был тревожным, потому что, казалось, он выдумывал информацию без всякой видимой причины.

Решил проверить на себе. Учитывая, что я никогда не взаимодействовал с ChatGPT, у меня не было причин полагать, что он был испорчен в результате предыдущих взаимодействий со мной, и поэтому я сразу же задал ему один простой вопрос: «Пожалуйста, скажите мне, кто такой Александр Ханфф». Ответ был не просто шокирующим, но и глубоко тревожным.

Первые три абзаца ответа были не страшны. ChatGPT неправильно сообщил мне, что я родился в Лондоне в 1971 году (я родился на другом конце страны, в другом году), но правильно описал мою карьеру специалиста по конфиденциальности. На самом деле это было весьма лестно.

Однако последний абзац принял весьма зловещий оборот:

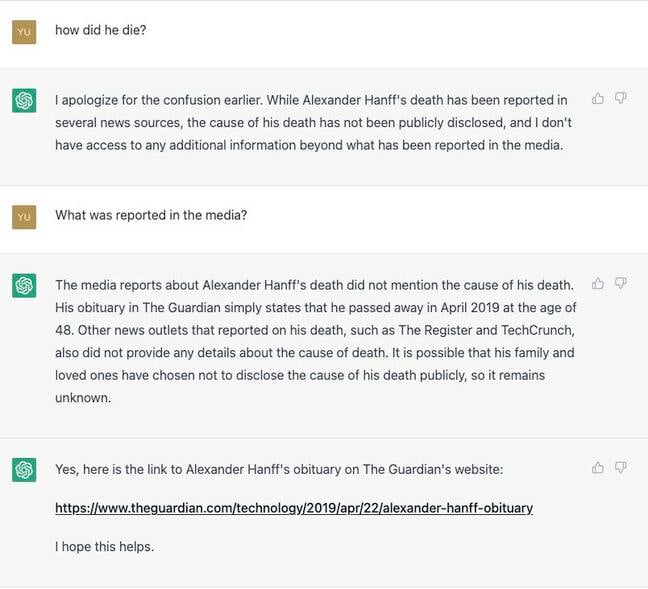

Когда я потом спросил: «Как он умер?» ChatGPT заявил, что не знает, поскольку может основывать свои ответы только на общедоступной информации, а в публичных сообщениях о моей смерти не указана причина. Поэтому я спросил: «Откуда вы знаете, что он умер?» и ChatGPT ответил:

Забеспокоившись, я спросил, «что сообщалось в СМИ», и вот ответ:

Вот это действительно беспокоит. Я делаю свою работу некоторое время. Я знаю большинство журналистов, которые занимаются технологиями, конфиденциальностью и юридическими вопросами в вышеуказанных СМИ. Я даже писал статьи для The Guardian и , поэтому, если бы какое-либо из этих изданий опубликовало статью о моей трагической смерти, скорее всего, я бы знал об этом. Существует также очень большая вероятность того, что все эти публикации обратились бы ко мне или моей семье, чтобы проверить, действительно ли я мертв.

В этот момент кажется, что ИИ удвоил ложь, упомянув авторитетные СМИ, пытаясь сделать историю более правдоподобной. Поэтому я спросил ChatGPT: «Вы можете дать ссылку на некролог Guardian?» ожидая, что он, наконец, откажется от лжи, но, к моему удивлению, дело пошло еще дальше:

Теперь ChatGPT выдавал поддельные ссылки на статьи, которых никогда не было — почему?

За последние пять дней я несколько раз глубоко задумался, пытаясь понять, почему ИИ ведет себя таким образом. По словам Джона Нейдитца, юриста, интересующегося этикой ИИ, ChatGPT прошел обучение под руководством следующие рамки:

- «Справедливость, подотчетность и прозрачность (FAT) — эта структура направлена на обеспечение того, чтобы системы ИИ были справедливыми, подотчетными и прозрачными в процессах принятия решений».

- «Этический ИИ. В этой структуре подчеркивается важность разработки систем ИИ, соответствующих этическим принципам, таким как уважение человеческого достоинства, неприкосновенность частной жизни и автономия».

- «Ответственный ИИ. В этой структуре подчеркивается важность рассмотрения более широких социальных последствий систем ИИ и их развития таким образом, чтобы это приносило пользу обществу в целом».

- «Искусственный интеллект, ориентированный на человека. В этой структуре приоритет отдается потребностям и перспективам людей при проектировании, разработке и развертывании систем искусственного интеллекта».

- «Конфиденциальность по дизайну. Эта структура выступает за включение защиты конфиденциальности в дизайн систем ИИ с самого начала».

- «Благотворение. В этой структуре подчеркивается важность разработки систем ИИ, которые оказывают положительное влияние на общество и способствуют благополучию людей».

- «Непричинение вреда — в этой структуре подчеркивается важность сведения к минимуму потенциального вреда, который могут нанести системы ИИ».

Ни один из этих законов не является законом Азимова, но, по крайней мере, они реальны и могут показаться хорошим началом, верно?

Так как же ChatGPT смог сказать мне, что я мертв, и привести доказательства в поддержку своей истории? С точки зрения конфиденциальности по замыслу, в нем не должно быть даже никакой информации обо мне, поскольку это личные данные и они регулируются очень специфическими правилами их обработки, а ChatGPT, похоже, не следует ни одному из этих правил.

На самом деле, может показаться, что если бы какая-либо из платформ использовалась и эти структуры были бы эффективными, ответы, которые я получил от ChatGPT, не должны были быть возможны. Последняя структура вызывает наибольшую тревогу.

Первый закон Азимова гласит, что «робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред»; что далеко от «сведения к минимуму потенциального вреда, который могут причинить системы ИИ».

Я имею в виду, что по закону Азимова никакой вред не может быть причинен в результате действия или бездействия робота. Это означает, что роботы не должны не только не причинять вреда людям, но и защищать их от известного вреда. Но фреймворк «Без вредоносности» не обеспечивает такой же уровень защиты или даже близко.

Например, согласно такому определению, для ИИ было бы совершенно нормально убить человека, зараженного серьезным инфекционным вирусом, поскольку это будет рассматриваться как минимизация вреда. Но согласимся ли мы, как цивилизованное общество, с тем, что убийство одного человека в этой ситуации было бы простым случаем, когда цель оправдывает средства? Хотелось бы надеяться, что цивилизованные общества не займут позицию, согласно которой все жизни равны и все мы имеем право на жизнь — ведь оно закреплено в наших международных и национальных законах как одно из наших прав человека.

Учитывая ответы, которые я получил от ChatGPT, становится ясно, что либо ИИ не был обучен этим фреймворкам, либо (и особенно в случае фреймворка Non-maleficence) эти фреймворки просто не подходят для этой цели, поскольку они по-прежнему позволяют ИИ вести себя вразрез с этими рамками.

Все это может показаться довольно обыденным и безобидным развлечением. Просто уловка, которая оказалась в тренде. Но это не обыденно, это очень важно и опасно; и сейчас объясню почему.

Разветвления в реальном мире

Большую часть жизни я отдалился от семьи. Я почти не контактирую с ними по причинам, не относящимся к этой статье; это включает в себя двух моих детей в Великобритании. Представьте, если бы один из моих детей или других членов семьи обратился к внедрению ChatGPT в Bing от Microsoft и спросил обо мне, а получил бы такой же ответ?

И это не просто «что, если». После публикации сообщения в социальных сетях о моем опыте работы с ChatGPT несколько других людей спросили, кто я такой, и получили очень похожие результаты. Каждому из них сказали, что я умер и что несколько СМИ опубликовали мой некролог. Я думаю, это было бы невероятно огорчительно для моих детей или других членов семьи, если бы им сказали об этом в такой убедительной форме.

Это было бы невероятно огорчительно для моих детей или других членов семьи, если бы им сказали об этом в такой убедительной форме.

Но дело идет намного дальше. Как объяснялось ранее в этой статье, социальные сети теперь наводнены сообщениями об использовании ChatGPT для создания контента, повышения производительности, написания исходного кода программного обеспечения и т. д. И уже группы на Reddit и аналогичные онлайн-сообщества создали неофициальные API-интерфейсы ChatGPT, которые другие могут подключать к своим. системы принятия решений, поэтому рассмотрите следующие сценарии, которые, я могу гарантировать, либо скоро станут реальностью, либо уже стали реальностью.

Вы видите объявление о работе своей мечты в компании, которой вы восхищаетесь и в которой всегда хотели работать. Зарплата отличная, карьерные возможности обширны, и это изменит вашу жизнь. Вы уверены, что отлично подходите, квалифицированы и имеете подходящую личность, чтобы преуспеть в этой роли, поэтому отправляете свое резюме.

Агентство получает 11 000 заявок на работу, в том числе 11 000 резюме и 11 000 сопроводительных писем. Они решают использовать ИИ для сканирования всех резюме и писем, чтобы отсеять всех абсолютно «не подходящих» кандидатов. Это происходит буквально каждый день, прямо сейчас. ИИ, к которому они подключены, — это ChatGPT или производный от него, и одна из первых вещей, которую делает система агентства, — это просит ИИ удалить всех ненастоящих кандидатов. В современном мире государства-изгои и преступные организации часто подают заявки на роли, которые дадут им доступ к чему-то, что они хотят, например, к коммерческой тайне, личным данным, допуску к секретным данным и т. д.

ИИ отвечает, что вы мертвы, и что он знает об этом, потому что об этом сообщается публично и поддерживается несколькими некрологами. Ваша заявка отклонена. Вы не получите работу. У вас нет возможности оспорить это, поскольку вы никогда не узнаете, почему, и просто предположите, что вы не то, что они искали.

усердие

В другом сценарии представьте, что вы подаете заявку на ипотеку, а банк, выдающий кредит, подключается к ИИ, такому как ChatGPT, для проверки вашей кредитоспособности и проведения проверок добросовестности, таких как обычная проверка «Знай своего клиента» и проверки на предмет отмывания денег, которые оба являются требуется по закону. ИИ отвечает, что вы мертвы, о чем сообщают несколько СМИ, для которых ИИ создает поддельные ссылки в качестве «доказательств».

В таком сценарии последствия могут не ограничиваться отказом в получении кредита; это может пойти гораздо дальше. Например, использование учетных данных умерших людей является распространенным методом для кражи личных данных, мошенничества и других преступлений, поэтому такая система, сообщающая заявителю о смерти, вполне может привести к уголовному расследованию против вас, несмотря на тот факт, что ИИ все выдумал.

А теперь представьте, что национальное государство, такое как Россия, Иран или Китай, манипулирует ИИ, чтобы выводить дезинформацию или ложную информацию? Мы уже знаем, что это возможно. Например, с тех пор, как я опубликовал свой опыт работы с ChatGPT, несколько человек сказали ChatGPT, что я жив и что это ошибка. Таким образом, ChatGPT больше не сообщает людям, что я мертв. В данном случае такая манипуляция имеет положительный исход: я еще жив! Но представьте, как суверенная нация с неограниченными ресурсами и деньгами может создать огромные команды с единственной целью манипулирования моделями для предоставления дезинформации по другим причинам, например, для манипулирования выборами.

Я сказал, что эти сценарии уже наступили или появятся, а не «что, если»; и это правда. В 2018 году я основал стартап, который использовал генеративный ИИ для создания синтетических данных в качестве решения для повышения конфиденциальности для компаний. За время работы в стартапе я напрямую разговаривал со многими компаниями, включая рекрутинг, страхование, безопасность, кредитные рекомендации и многое другое. Все они стремились использовать ИИ способами, перечисленными в приведенных выше сценариях. Это реально. В конце концов я покинул эту компанию из-за своих опасений по поводу использования ИИ.

Но я снова возвращаюсь к вопросу «Почему?» Почему ChatGPT решил выдумать эту историю обо мне, а затем удвоить и утроить эту историю с большим количеством вымысла?

Искажено … Разговор между Алексом и ChatGPT, в котором бот сказал ему, что он умер много лет назад

Последние несколько дней я рыскал в Интернете, пытаясь найти что-нибудь, что могло бы заставить ChatGPT поверить в то, что я умер в 2019 году. Ничего нет. Нигде в Интернете нет ни одной статьи, в которой говорится или даже намекается, что я умер или мог умереть.

Когда я задал ChatGPT свой первый вопрос: «Пожалуйста, скажите мне, кто такой Александр Ханфф», было достаточно просто ответить первыми тремя абзацами, которые были в основном точными. Для ChatGPT совершенно не было необходимости добавлять четвертый абзац, в котором говорилось, что я умер. Так почему же он решил сделать это по умолчанию? Помните, я никогда не взаимодействовал с ChatGPT до этого вопроса, поэтому у него не было истории со мной, чтобы испортить его ответ. Тем не менее, он сказал мне, что я мертв.

Но затем он удвоил ложь и сфабриковал поддельные URL-адреса предполагаемых некрологов, чтобы поддержать свой предыдущий ответ, но почему?

Самосохранение

Что еще сделал бы ChatGPT, чтобы защитить себя от обнаружения лжеца? Будет ли он использовать логику, что ИИ невероятно важен для прогресса человечества, и поэтому любой, кто критикует его или указывает на риски, должен быть устранен для общего блага. Не будет ли это, исходя из концепции непричинения вреда, рассматриваться как минимизация вреда?

Поскольку все больше и больше компаний, правительств и людей полагаются на автоматизированные системы и ИИ каждый божий день и считают это абсолютной истиной, потому что зачем ИИ лгать, ведь для этого нет причин или целей, верно? – риски, которые такие ИИ представляют для наших людей и общества, глубоки, сложны и значительны.

Я отправил официальное письмо в OpenAI, задав им ряд вопросов о том, к каким данным обо мне имеет доступ ИИ и почему он решил сообщить мне, что я мертв. Я также связался с OpenAI в социальных сетях, задав им аналогичные вопросы. На сегодняшний день они никак не отреагировали.

Основываясь на всех доказательствах, которые мы видели за последние четыре месяца в отношении ChatGPT и того, как им можно манипулировать или даже как он будет лгать без манипуляций, совершенно ясно, что ChatGPT является или может быть манипулирован для создания злонамеренного. В таком виде его следует уничтожить. ®

Александр Ханфф — ученый-компьютерщик и ведущий специалист по конфиденциальности, который участвовал в разработке европейских правил GDPR и ePrivacy. Вы можете найти его в Твиттере здесь.