Ученые-компьютерщики утверждают, что они придумали способ помешать системам машинного обучения манипулировать изображениями в цифровом виде и создавать дипфейки.

В наши дни вы можете не только создавать изображения с нуля, используя модели ИИ — просто дайте им письменное описание, и они создадут соответствующие изображения — вы также можете манипулировать существующими изображениями, используя ту же технологию. Вы можете дать этим обученным системам изображение и описать, как вы хотите его изменить, или использовать графический интерфейс, чтобы управлять ими, и они работают.

Это создает потенциал для ужасающего будущего, в котором социальные сети наводнены автоматизированной массовой дезинформацией или люди будут шантажироваться из-за снимков, искаженных машинами. Если никто не может отличить подделки от настоящих, они могут быть столь же разрушительными.

Один из способов предотвратить это — наносить водяные знаки или цифровые подписи на изображения и другой контент, чтобы манипуляции можно было обнаружить. Другой путь, предложенный учеными из Массачусетского технологического института, заключается в том, чтобы спроектировать снимки таким образом, чтобы модели ИИ вообще не могли их изменить.

«Рассмотрите возможность мошеннического распространения фальшивых катастрофических событий, таких как взрыв на значимой достопримечательности», — сказал Хади Салман, аспирант факультета электротехники и информатики университета, который работал над этим проектом.

«Этот обман может манипулировать рыночными тенденциями и общественными настроениями, но риски не ограничиваются публичной сферой. Личные изображения могут быть ненадлежащим образом изменены и использованы для шантажа, что приведет к значительным финансовым последствиям при крупномасштабном применении».

Салман вполне может быть прав. Дипфейки уже использовались для распространения дезинформации, обмана и преследования пользователей сети, а изображения, созданные искусственным интеллектом, становились все более реалистичными. Он предупредил, что по мере совершенствования технологии в будущем люди смогут создавать видео и с реалистичным ложным звуком.

Вот почему Салман и его коллеги решили разработать программное обеспечение для машинного обучения, получившее название PhotoGuard, чтобы не дать злоумышленникам злоупотребить этими инструментами для манипулирования контентом.

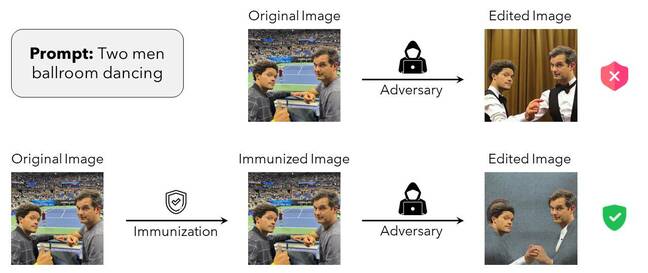

Изображения в основном обрабатываются моделями ML как массивы чисел. PhotoGuard настраивает эти массивы, чтобы помешать другим моделям машинного обучения правильно воспринимать входное изображение, чтобы в конечном итоге с изображением нельзя было манипулировать. Пиксели остаются нетронутыми с точки зрения людей, поэтому защищенное изображение выглядит одинаково для человеческого глаза, но не для компьютера.

В приведенном ниже примере на фотографии изображены шутники американского телевидения Тревор Ноа и Майкл Коста на Открытом чемпионате США. Оригинальная — незащищенная — фотография может быть изменена с помощью модели распространения, управляемой текстом, чтобы заставить их появиться в совершенно другой обстановке: в бальном зале, танцующем вместе. Однако с применением изменений PhotoGuard модель диффузии отбрасывается невидимыми возмущениями и не может полностью изменить изображение.

Рисунок из статьи MIT PhotoGuard, показывающий, как в основном работает эта иммунизация данных от манипуляций. Нажмите, чтобы увеличить

«В этой атаке мы искажаем входное изображение, чтобы окончательное изображение, сгенерированное [large diffusion model] — это конкретное целевое изображение (например, случайный шум или серое изображение)», — написали ученые в своей не рецензируемой статье с описанием PhotoGuard, опубликованной на ArXiv.

Строго говоря, команда Массачусетского технологического института называет такой подход диффузной атакой. Его цель — обмануть ИИ, манипулирующий изображениями, и заставить его эффективно игнорировать любое текстовое приглашение, которое ему было дано.

Существует второй, более простой метод, называемый атакой кодировщика, который пытается заставить манипулирующий ИИ воспринимать фотографию как что-то другое, например серый квадрат, что препятствует ее автоматическому редактированию. Результат в любом случае более или менее одинаков: попытки использовать ИИ для управления изображениями сходят с ума.

«При применении атаки кодировщика наша цель — сопоставить представление исходного изображения с представлением целевого изображения (серое изображение)», — написала команда в своей статье. «Наша (более сложная) диффузионная атака, с другой стороны, направлена на то, чтобы нарушить процесс диффузии, манипулируя всем процессом для создания изображения, напоминающего заданное целевое изображение (серое изображение)».

Они провели свои эксперименты с Stable Diffusion Model v1.5 от Stability AI и отметили, что, хотя PhotoGuard может защитить изображения от цифрового изменения AI, его трудно применять на практике. Во-первых, диффузионная атака требует значительной мощности графического процессора, поэтому, если у вас нет под рукой такого кремния, вам не повезло.

Исследователи утверждают, что на самом деле ответственность должна лежать на организациях, разрабатывающих эти инструменты ИИ, а не на отдельных лицах, пытающихся защитить свои изображения.

«Совместный подход с участием разработчиков моделей, платформ социальных сетей и политиков представляет собой надежную защиту от несанкционированных манипуляций с изображениями. Работа над этой насущной проблемой сегодня имеет первостепенное значение», — заявил Салман.

«И хотя я рад внести свой вклад в это решение, необходимо проделать большую работу, чтобы сделать эту защиту практичной. Компании, разрабатывающие эти модели, должны инвестировать в разработку надежных средств защиты от возможных угроз, создаваемых этими инструментами ИИ. эра генеративных моделей, давайте в равной степени стремиться к потенциалу и защите».

PhotoGuard не идеальное решение. Если изображение доступно для загрузки без какой-либо защиты, злоумышленник может получить эту незащищенную версию фотографии, отредактировать ее с помощью ИИ и распространить. Кроме того, обрезка, поворот или применение некоторых фильтров могут нарушить возмущения PhotoGuard.

Правление MIT заявило, что они работают над тем, чтобы сделать свое программное обеспечение с открытым исходным кодом (естественно, с лицензией MIT) более устойчивым к таким модификациям.

Регистр попросил Салмана для дальнейшего комментария. ®