С ростом популярности моделей большого языка и приложений на основе искусственного интеллекта практически каждая крупная техническая компания начала создавать оборудование, способное обеспечить максимальную производительность в рабочих нагрузках искусственного интеллекта. Черт возьми, даже потребительские ноутбуки начали оснащаться совершенно новым типом процессоров под названием NPU, обеспечивающим превосходную производительность при выполнении каждой задачи, связанной с искусственным интеллектом.

Но что, если бы вы могли запускать генеративные модели ИИ локально на крошечном SBC? Оказывается, вы можете настроить API Ollama для запуска практически всех популярных LLM, включая Orca Mini, Llama 2 и Phi-2, прямо с вашей платы Raspberry Pi!

Обзор Raspberry Pi 5: Святой Грааль DIY-проектов стал еще лучше (и реже)

Raspberry Pi 5 — один из самых мощных SBC потребительского уровня. К сожалению, его ограниченный ассортимент означает, что вам будет сложно его найти.

Что вам понадобится

Плата Raspberry Pi станет сердцем этого проекта. Вам также понадобится карта microSD для хранения ОС и LLM. Поскольку эти модели могут занимать много места, я предлагаю приобрести карту microSD емкостью не менее 32 ГБ. Возможно, вы захотите приобрести вариант Raspberry Pi 4/5 объемом 8 ГБ, поскольку Оллама рекомендует минимум 8 ГБ ОЗУ, если вы хотите запускать 7B LLM без значительных задержек.

Наконец, вам понадобится установленная на Raspberry Pi ОС. Хотя технически вы можете запускать LLM на ОС Raspberry Pi или Ubuntu, лучше всего использовать чистую установку Raspberry Pi OS Lite. Это связано с тем, что генеративные модели искусственного интеллекта очень требовательны к этим SBC, и вам лучше отказаться от графического интерфейса в пользу легкой настройки CLI.

Установка Raspberry Pi OS Lite

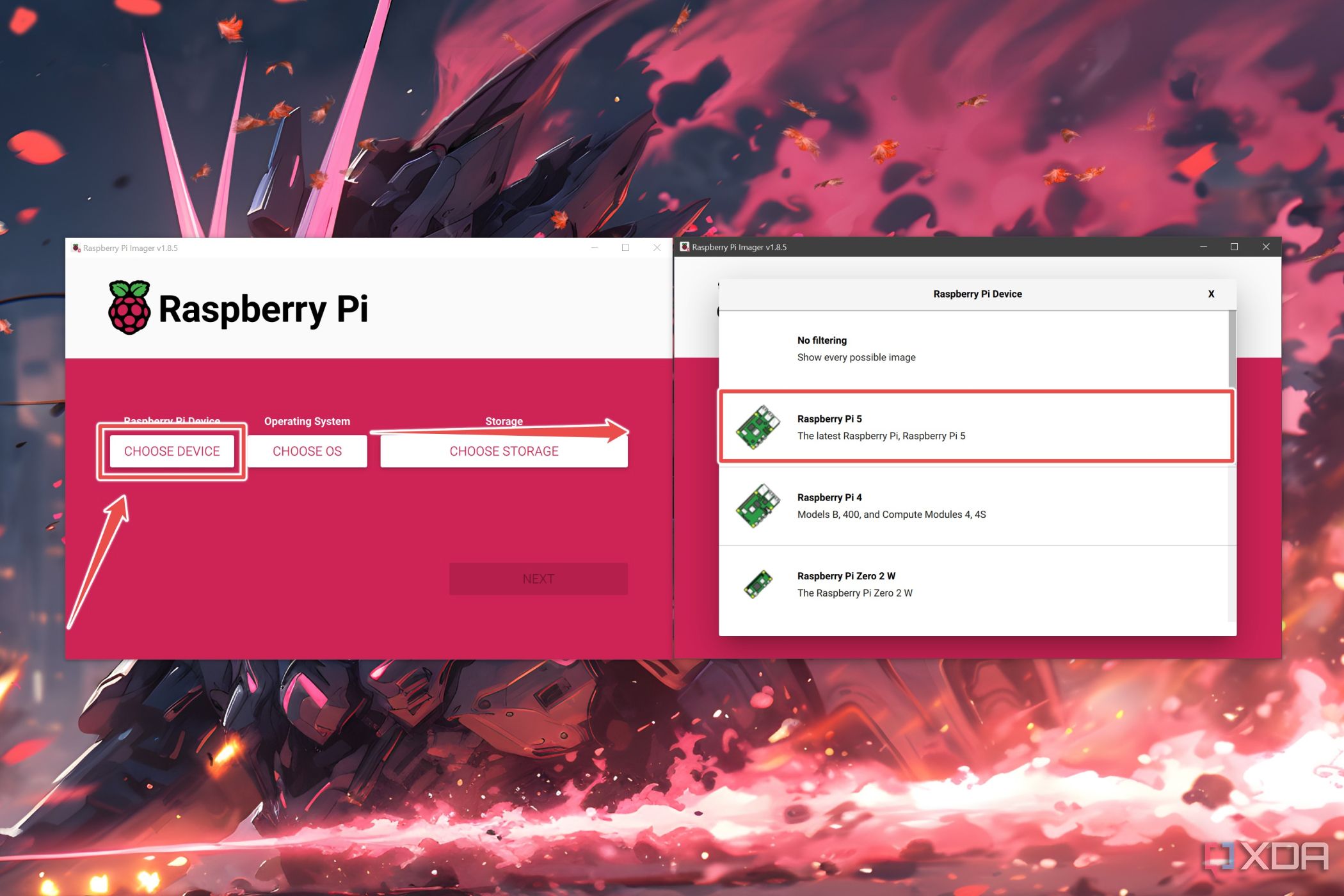

Сначала мы установим операционную систему Raspberry Pi на базе CLI с помощью инструмента Raspberry Pi Imager. Хотя вы можете использовать другие инструменты для прошивки, такие как Balena Etcher или Rufus, вы можете использовать настройки ОС официального приложения для создания образов, чтобы легко подключиться по SSH к Raspberry Pi со своего ПК.

- Загрузите и установите Raspberry Pi Imager по официальной ссылке.

- Запустите инструмент с правами администратора.

- Нажмите на Выберите устройство и выберите свой Модель малины Пи.

- Выбирать Выберите ОС и отправляйтесь в ОС Raspberry Pi (другое).

- Выбирать ОС Raspberry Pi Lite (64-разрядная версия).

- Нажмите на Выберите хранилищевыберите карта microSD куда вы хотите прошить файлы ОС, и нажмите Следующий.

- Нажимать Изменить настройки во всплывающем окне.

- Внутри Вкладка «Общие»введите Имя пользователя и Пароль.

- Перейдите к Услуги вкладку и проверьте переключатели рядом с Включить SSH и Использовать аутентификацию по паролю варианты, прежде чем нажать на Сохранять.

- Выбирать Да когда Raspberry Pi Imager запросит подтверждение.

После установки Raspberry Pi OS Lite вы можете использовать ее как есть или использовать SSH, следуя этому руководству.

Настройка Ollama на Raspberry Pi

К счастью, установка Ollama — самая простая часть этой статьи, поскольку все, что вам нужно сделать, это ввести следующую команду и нажать Входить:

curl -fsSL https://ollama.com/install.sh | sh

Затем пришло время настроить LLM для локального запуска на Raspberry Pi.

- Запустите Олламу с помощью этой команды:

sudo systemctl start ollama

- Установите выбранную вами модель с помощью тянуть команда. В этом руководстве мы будем использовать 3B LLM Orca Mini.

ollama pull llm_name

Обязательно замените llm_name с совместимым с Ollama LLM, который вы хотите загрузить.

- Выполните следующую команду, чтобы запустить только что загруженный LLM.

ollama run llm_name

- Если вы хотите выйти из LLM, выполните следующую команду:

/bye

- (Необязательно) Если вам не хватает места, вы можете использовать команду rm для удаления модели.

ollama rm llm_name

Какие LLM хорошо работают на Raspberry Pi?

Хотя Ollama поддерживает несколько моделей, вам следует придерживаться более простых, таких как Gemma (2B), Dolphin Phi, Phi 2 и Orca Mini, поскольку запуск LLM может сильно утомлять ваш Raspberry Pi. Если у вас есть плата Pi с 8 ГБ ОЗУ, вы можете попытаться запустить LLM 7B, хотя производительность будет не очень впечатляющей.

Я попробовал использовать Orca Mini и Phi 2 на своем Raspberry Pi 5, и они работали довольно хорошо. Однако ограничения SBC стали очевидными в тот момент, когда я запустил модели 7B, такие как Mistral и Llama. Если не считать длительной задержки после ввода подсказки, LLM довольно медленно генерировали текст: средняя скорость составляла 1–2 токена в секунду.

Хотя превращение вашей платы Raspberry Pi в текстовый генератор AI — небольшой забавный проект, крошечное устройство едва может выдержать свой вес при запуске более сложных LLM. Таким образом, вам следует рассмотреть возможность приобретения мощных компьютеров с искусственным интеллектом, если вы хотите более быстрого ответа от ваших любимых LLM.

Как запустить Llama 2 локально на Mac или ПК

Если вы слышали о Llama 2 и хотите запустить ее на своем ПК, вы можете легко сделать это с помощью нескольких бесплатных программ.