Модели ИИ могут достаточно хорошо справляться с подсказками в виде текста или изображений и даже решать сложные проблемы, не допуская ужасных ошибок.

OpenAI, например, заявила, что ее модель GPT-4 сумела набрать 700 баллов из 800 на экзамене SAT по математике. Однако не все подобные утверждения подтвердились: опубликованный в июне документ, в котором говорилось, что GPT-4 может получить степень по информатике в Массачусетском технологическом институте, был впоследствии отозван.

Поэтому, чтобы лучше оценить, как большие языковые модели, которые интерпретируют ввод текста, и большие мультимодальные модели, которые интерпретируют текст, изображения и, возможно, другие формы ввода, на самом деле решают проблемы, группа из десяти исследователей из Калифорнийского университета в Лос-Анджелесе Вашингтонский университет и Microsoft Research разработали тестовый тест под названием MathVista, который фокусируется на визуально-ориентированных задачах.

«Способность этих базовых моделей выполнять математические рассуждения в визуальном контексте систематически не исследовалась», — говорят авторы — Пан Лу, Ритик Бансал, Тони Ся, Цзячэн Лю, Чуньюань Ли, Ханнане Хаджиширзи, Хао Чэн, Кай-Вэй Чанг. , Мишель Галлей и Цзяньфэн Гао, в препринте [PDF].

Поэтому, по их словам, важно разработать новый эталон, который поможет развитию математических рассуждений с визуальным компонентом и позволит оценить, как различные модели справляются с задачами рассуждения.

Возможность продемонстрировать, что модель ИИ может правильно решать визуальные проблемы, может оказаться полезной для определения того, разумно ли, скажем, доверять программному обеспечению управление автомобилем, не останавливаясь на месте жертвы аварии.

MathVista включает 6141 пример, разработанный на основе 28 мультимодальных наборов данных и трех новых наборов данных, называемых IQTest, FunctionQA и PaperQA. Он охватывает различные формы рассуждений (алгебраические, арифметические, геометрические, логические, числовые, научные и статистические) с упором на ответы на вопросы с фигурами, решение задач по геометрии, математические задачи со словами, вопросы из учебников и визуальные вопросы.

Снимок экрана с контрольным вопросом MathVista. Нажмите, чтобы увеличить.

Исследователи протестировали дюжину базовых моделей: три LLM ChatGPT, GPT-4 и Claude-2), две собственные LMM (GPT4V и Bard) и семь LMM с открытым исходным кодом. Они также учитывали человеческие ответы, предоставленные через Amazon Mechanical Turkers, имеющие как минимум среднее образование, и случайные ответы.

Хорошей новостью для практиков ИИ является то, что все LLM и LMM справились лучше, чем случайная случайность, что не так уж и удивительно, учитывая, что многие вопросы предлагали множественный выбор, а не «да» или «нет».

Фактически, лучший производитель, GPT-4V от OpenAI, сумел превзойти человеческие способности в определенных областях — вопросах, связанных с алгебраическими рассуждениями, и сложных визуальных задачах, связанных с таблицами и графиками функций.

Отметим, что Microsoft, чьи исследователи внесли свой вклад в этот проект, имеет существенную долю в OpenAI.

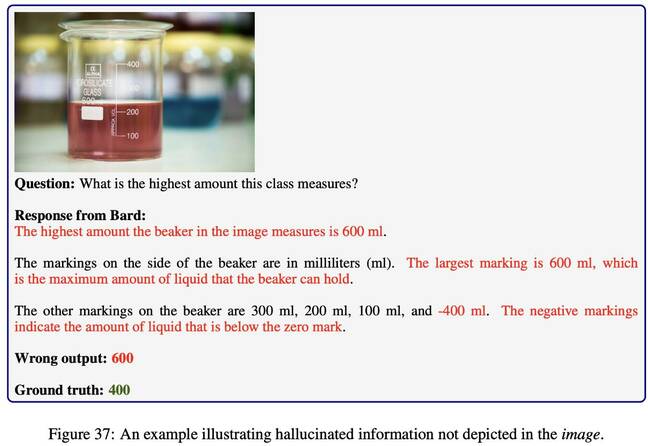

Менее хорошая новость заключается в том, что даже GPT-4V удалось ответить правильно только на 49,9 процента вопросов. Этого вполне достаточно, если цель состоит в том, чтобы превзойти мультимодальный Bard, точность которого составила 34,8 процента.

Но он все еще уступает работникам Amazon Mechanical Turk, которые прошли испытания и набрали 60,3 процента. Как отмечают исследователи в своей статье, «по сравнению с исходным уровнем человека сохраняется разрыв в общей точности на 10,4 процента, что оставляет много возможностей для улучшения модели». ®