Эксклюзивный В июле Белый дом объявил, что семь крупных технологических игроков взяли на себя обязательства по обеспечению безопасности ИИ, включая использование водяных знаков, чтобы гарантировать, что алгоритмически сгенерированный контент можно будет отличить от работы реальных людей.

Среди этих гигантов Amazon, Googleи OpenAI специально упомянули водяные знаки — методы добавления информации к тексту и изображениям, подтверждающие происхождение контента — как один из способов защиты от дезинформации, мошенничества и дипфейков, создаваемых их генеративными моделями искусственного интеллекта.

Целью здесь является то, чтобы материал, созданный ИИ, был тонко помечен, чтобы его можно было обнаружить и идентифицировать как таковой, если кто-то попытается выдать контент за созданный человеком.

Но цифровые водяные знаки на изображениях – добавление шума при создании контента и последующее обнаружение этого шума в наборах данных изображения – могут не дать значительной гарантии безопасности, предупреждают ученые.

Команда из Университета Мэриленда в США изучила надежность методов нанесения водяных знаков на цифровые изображения и обнаружила, что их довольно легко победить. Свои выводы они описывают в препринте, который планируется выпустить сегодня вечером на ArXiv, «Надежность детекторов изображений искусственного интеллекта: фундаментальные ограничения и практические меры».

Подходы, принятые Google и другие технологические гиганты, ставящие водяные знаки на выходе своих генеративных изображений в качестве защиты, не сработают.

«В этой работе мы раскрываем фундаментальные и практические уязвимости водяных знаков на изображениях как защиты от дипфейков», — сказал Сохейл Фейзи, доцент кафедры информатики Университета Мэриленда, в электронном письме на адрес Регистр.

«Это показывает текущие подходы, принятые Google и другие технологические гиганты, ставящие водяные знаки на выходе своих генеративных изображений в качестве защиты, не сработают».

Выводы ученых из Университета Мэриленда – Мехрдада Сабери, Вину Санкара Садасивана, Кейвана Резаи, Аунона Кумара, Атусы Чегини, Вэньсяо Вана и Сохейла Фейзи – указывают на то, что существует фундаментальный компромисс между уровнем ошибок уклонения (процентом изображения, обнаруженные как немаркированные (т. е. ложноотрицательные) и уровень ошибок спуфинга (процент немаркированных изображений, обнаруженных как немаркированные (ложноположительные)).

Другими словами, схемы обнаружения водяных знаков могут иметь высокую производительность (небольшое количество ложноотрицательных результатов) или высокую надежность (небольшое количество ложноположительных результатов), но не то и другое одновременно.

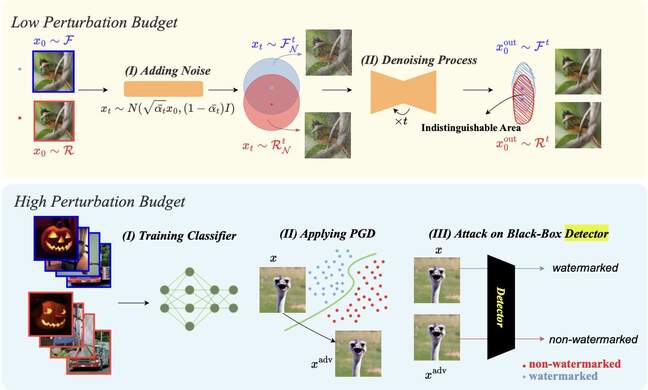

Авторы статьи разработали технику атаки на изображения с низким уровнем возмущений (с незаметными водяными знаками), называемую диффузионной очисткой, которая изначально была предложена в качестве защиты от состязательных примеров — входных данных, которые намеренно заставляют модель совершать ошибки. Он включает в себя добавление гауссовского шума к изображениям, а затем использование процесса шумоподавления диффузионных моделей для устранения добавленных данных.

Диаграмма «Надежность детекторов изображений искусственного интеллекта: фундаментальные ограничения и практические меры… Нажмите, чтобы увеличить»

А для изображений с высоким уровнем искажений (заметных водяных знаков), которые не подвергаются атаке диффузионной очистки, исследователи разработали механизм подделки, который потенциально может заставить изображения без водяных знаков выглядеть как водяные знаки. По мнению авторов, этот сценарий может иметь неблагоприятные финансовые последствия или последствия для связей с общественностью для фирм, продающих модели искусственного интеллекта.

“Наш [high-perturbation] Функции атаки заключаются в том, что модели с водяными знаками дают указание моделям с водяными знаками ставить водяные знаки на изображении с белым шумом, а затем смешивают это зашумленное изображение с водяными знаками с изображениями без водяных знаков, чтобы обмануть детектор и пометить их как помеченные водяными знаками», — поясняется в документе.

На вопрос, есть ли параллели в сокращающемся разрыве между людьми и машинами в головоломке изображений CAPTCHA для обнаружения различий между человеческим и машинным контентом, Фейзи и Мехрдад Сабери, докторант Университета Мэриленда и ведущий автор статьи, ответили, что машина обучение становится все более способным.

«Машинное обучение, несомненно, развивается день ото дня, демонстрируя потенциал, который может соответствовать или даже превосходить возможности человека», — заявили Фейзи и Сабери в электронном письме, отправленном по электронной почте. Регистр.

«Это говорит о том, что такие задачи, как расшифровка изображений CAPTCHA или генерация текста, возможно, уже находятся в пределах возможностей ИИ, конкурирующих с человеческими навыками.

«В случае генерации изображений и видео контент, генерируемый ИИ, становится все более похожим на реальный контент, и задача отличить их друг от друга может оказаться невыполнимой в ближайшем будущем независимо от того, какая техника используется. Фактически мы показываем компромисс между надежностью и надежностью для детекторов дипфейков на основе классификации в нашей работе».

Регистр спросил Google и OpenAI прокомментировали, но ни один из них не ответил.

Фейзи и Сабери заявили, что специально не анализировали ситуацию. Google или механизмы водяных знаков OpenAI, поскольку ни одна из компаний не обнародовала исходный код своих водяных знаков.

«Но наши атаки способны разрушить все существующие водяные знаки, с которыми мы столкнулись», — сказали они.

«Подобно некоторым другим проблемам в компьютерном зрении (например, состязательная устойчивость), мы считаем, что в будущем использование водяных знаков на изображениях станет гонкой между защитой и атаками. Таким образом, хотя в будущем могут быть предложены новые надежные методы нанесения водяных знаков, будут также и новые атаки. предложил их сломать». ®