По горячим следам Make-A-Video Меты, Google заявил в среду, что также построил систему преобразования текста в видео на базе искусственного интеллекта. Это называется Imagen Video.

Осмелимся сказать, что публичная демонстрация Make-A-Video на прошлой неделе побудила Big G внезапно начать кричать о собственной конкурирующей системе, чтобы не выглядело так, будто она отстала от команды Марка Цукерберга. Или, возможно, Мета узнала о Googleзапланированное объявление, и помчались, чтобы испортить его своим собственным открытием. Это кажется слишком большим совпадением.

При наличии текстовой подсказки, такой как «ростки в форме текста «Imagen Video», выходящие из книги сказок. Плавное видео», Googleпрограммное обеспечение генерирует последовательность изображений для создания короткого клипа, как показано ниже.

Prompt: "Sprouts in the shape of text 'Imagen Video' coming out of a fairytale book."Model Output: pic.twitter.com/FVgnM0UAAn

— Durk Kingma (@dpkingma) October 5, 2022

Есть множество других примеров полностью сфабрикованных моделью кадров из подсказок, таких как «плюшевый мишка, бегущий по Нью-Йорку» или «невероятно детализированная научно-фантастическая сцена, действие которой происходит на чужой планете, вид на рынок. Pixel искусство.”

Imagen Video основывается на Googleпредыдущая система преобразования текста в изображение, Imagen, была запущена в мае. Однако вместо одного неподвижного изображения Imagen Video строит видео из нескольких выходных кадров.

Системы преобразования текста в видео требуют больше вычислительных ресурсов для обучения и запуска, чем системы преобразования текста в изображение. Imagen Video, например, состоит из семи типов моделей. Во-первых, он должен не просто генерировать кадр из своей текстовой подсказки, но и предсказывать, какими будут следующие кадры, чтобы сформировать последовательную движущуюся анимацию — каждый кадр представляет собой небольшое развитие предыдущего — а не серию связанных изображений, которые воспроизводятся. спина выглядела бы беспорядочным беспорядком.

«Imagen Video генерирует видео высокого разрешения с каскадными моделями диффузии», — говорится в сообщении. Google исследовательская записка.

«Первый шаг — взять входную текстовую подсказку и закодировать ее в текстовые вложения с помощью текстового кодировщика T5.

Затем базовая модель распространения видео генерирует 16-кадровое видео с разрешением 24×48 и скоростью три кадра в секунду; затем следуют несколько моделей временного суперразрешения (TSR) и пространственного суперразрешения (SSR) для повышения дискретизации и генерации итоговое видео из 128 кадров с разрешением 1280×768 и частотой 24 кадра в секунду — в результате получается 5,3 секунды видео высокой четкости».

Как и Make-A-Video компании Meta, качество GoogleИзображение Imagen Video несколько размыто. Края изображений размыты, а разрешение пока невелико. Однако исследования и разработки в области генеративных визуальных моделей продвигаются быстро, и это будет лишь вопросом времени, когда новая архитектура будет создавать более четкие поддельные видео в высоком разрешении в течение более длительных периодов времени.

Пример, приведенный Googleкак Imagen Video генерирует клип, кадр за кадром

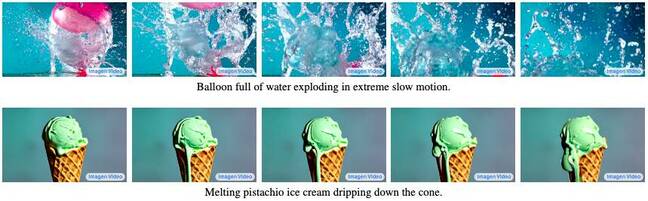

Эти модели показывают, что компьютеры хорошо изучают логическую последовательность событий для имитации таких событий, как лопание воздушного шара с водой или таяние мороженого. Боффинс в Google Брейн описал Imagen Video как «согласованное во времени» и «хорошо соответствующее заданной подсказке» в исследовательской статье, не прошедшей экспертную оценку. [PDF].

внутренний Google Для обучения Imagen Video использовался набор данных, состоящий из 14 миллионов образцов видео-текста и 60 миллионов пар изображение-текст, а также информация из общедоступного набора данных изображения-текста LAION-400M.

«Генерационные модели видео можно использовать для положительного воздействия на общество, например, путем усиления и расширения человеческого творчества. Однако эти генеративные модели также могут использоваться не по назначению, например, для создания поддельного, разжигающего ненависть, явного или вредоносного контента», — говорят исследователи. Также известно, что набор данных LAION-400M содержит порнографические и другие проблемные изображения.

Хотя команда применила фильтры контента, чтобы блокировать неприятные текстовые подсказки или изображения в видеороликах, созданных моделью, Imagen Video по-прежнему склонен создавать контент с «социальными предубеждениями и стереотипами» и пока небезопасен для экспериментов. «Мы решили не публиковать модель Imagen Video или ее исходный код до тех пор, пока эти опасения не будут устранены», — заключили они.

Так что, как и игрушка Меты, Imagen Video недоступен для широкой публики, возможно, заставляя их публиковать больше инструментов для найма — эй, давай поработай над такими крутыми штуками – чем что-либо еще прямо сейчас. ®