По словам пары исследователей, люди больше не могут достоверно отличить настоящее человеческое лицо от изображения лица, созданного искусственным интеллектом.

Два ученых — Софи Найтингейл с факультета психологии Ланкастерского университета в Великобритании и Хэни Фарид с факультета электротехники и компьютерных наук Беркли в Калифорнии — изучили человеческие оценки как реальных фотографий, так и изображений, синтезированных искусственным интеллектом, и пришли к выводу, что никто не может достоверно сказать разница больше.

В одной части исследования – опубликованной в Труды Национальной академии наук США – люди идентифицировали поддельные изображения только в 48,2% случаев.

В другой части исследования участников обучали и давали обратную связь, чтобы помочь им распознать подделки. Хотя эта когорта действительно замечала настоящих людей в 59% случаев, их результаты на тот момент стабилизировались.

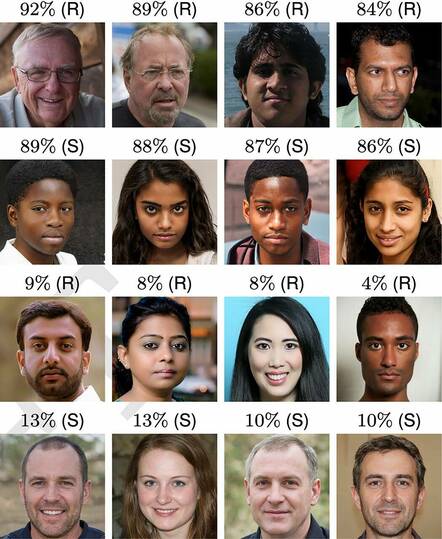

Лица, использованные в исследовании. нажмите, чтобы увеличить

В третьей части исследования участники оценили лица как «заслуживающие доверия» по шкале от одного до семи. Поддельные лица были оценены как более надежнее, чем настоящие.

«Улыбающееся лицо с большей вероятностью будет оценено как заслуживающее доверия, но 65,5% наших настоящих лиц и 58,8% искусственных лиц улыбаются, поэтому одно только выражение лица не может объяснить, почему синтетические лица оцениваются как заслуживающие большего доверия», — пишут исследователи. .

Поддельные изображения были сформированы с использованием генеративно-состязательных сетей (GAN), класса сред машинного обучения, в которых две нейронные сети соревнуются друг с другом, пока сеть не научится создавать более качественный контент.

Техника начинается со случайного массива пикселей и итеративно учится создавать лицо. Тем временем дискриминатор учится обнаруживать синтезированное лицо после каждой итерации. Если это удается, он наказывает генератор. В конце концов, дискриминатор не может отличить реальные лица от синетезированных и… вуаля! – видимо, и человек не может.

Окончательные изображения, использованные в исследовании, включали разнообразный набор из 400 реальных и 400 синтезированных лиц, представляющих чернокожих, южноазиатских, восточноазиатских и белых лиц. Были включены мужские и женские лица — в отличие от предыдущих исследований, в которых в основном использовались белые мужские лица.

Белые лица были классифицированы наименее точно, а белые лица мужчин были классифицированы еще менее точно, чем белые лица женщин.

«Мы предполагаем, что белые лица труднее классифицировать, потому что они чрезмерно представлены в обучающем наборе данных StyleGAN2 и поэтому более реалистичны», — объяснили исследователи.

Ученые заявили, что, хотя создание реалистичных лиц является успешным, оно также создает потенциальные проблемы, такие как несогласованные интимные образы (часто ошибочно называемые «порно-месть»), мошенничество и кампании по дезинформации как гнусные варианты использования поддельных изображений. Они писали, что такая деятельность имеет «серьезные последствия для отдельных людей, обществ и демократий».

Авторы предложили тем, кто разрабатывает такие технологии, подумать, перевешивают ли преимущества риски, а если нет, то просто не создавать технологию. Возможно, после признания того, что технология с большими недостатками для некоторых неотразима, они рекомендовали параллельную разработку мер безопасности, включая установленные правила, которые уменьшают потенциальный вред, причиняемый технологиями синтетических носителей.

В настоящее время предпринимаются усилия по улучшению обнаружения дипфейков и подобных медиа, например, создание прототипа программного обеспечения, способного обнаруживать изображения, сделанные с помощью нейронных сетей. В прошлом году сотрудники Мичиганского государственного университета (MSU) и Facebook AI Research (FAIR) даже предложили архитектуру нейронной сети, используемой для создания изображений.

Но Регистр рекомендует не принимать какие-либо усилия Meta по развенчанию дипфейков за… хм… чистую монету. В конце концов, его основатель, как известно, сам выкладывал изображения, которые никогда не будут Когда-либо покинуть зловещую долину, тем самым доказав, что, какой бы узкой ни стала эта долина в результате этого исследования, она останется здесь. ®