Поскольку AI Hype проникает в Интернет, лидеры технологий и бизнеса уже ищут следующий шаг. AGI, или искусственный общий интеллект, относится к машине с человеческим интеллектом и возможностями. Если сегодняшние системы ИИ находятся на пути к AGI, нам понадобятся новые подходы, чтобы такая машина не работала против человеческих интересов.

К сожалению, у нас нет ничего такого элегантного, как три закона робототехники Исаака Асимова. Исследователи в DeepMind работали над этой проблемой и выпустили новую техническую статью (PDF), которую вы можете скачать по своему усмотрению.

Он содержит огромное количество деталей, включая 108 страниц до ссылки. В то время как некоторые в области искусственного интеллекта считают, что AGI-это мечта о трубе, авторы DeepMind Paper Project, который может произойти к 2030 году. Имея это в виду, они стремились понять риски синтетического интеллекта, похожий на человека, который, как они признают, могут привести к «серьезным вредам».

Все способы, которыми Аги может высосать для человечества

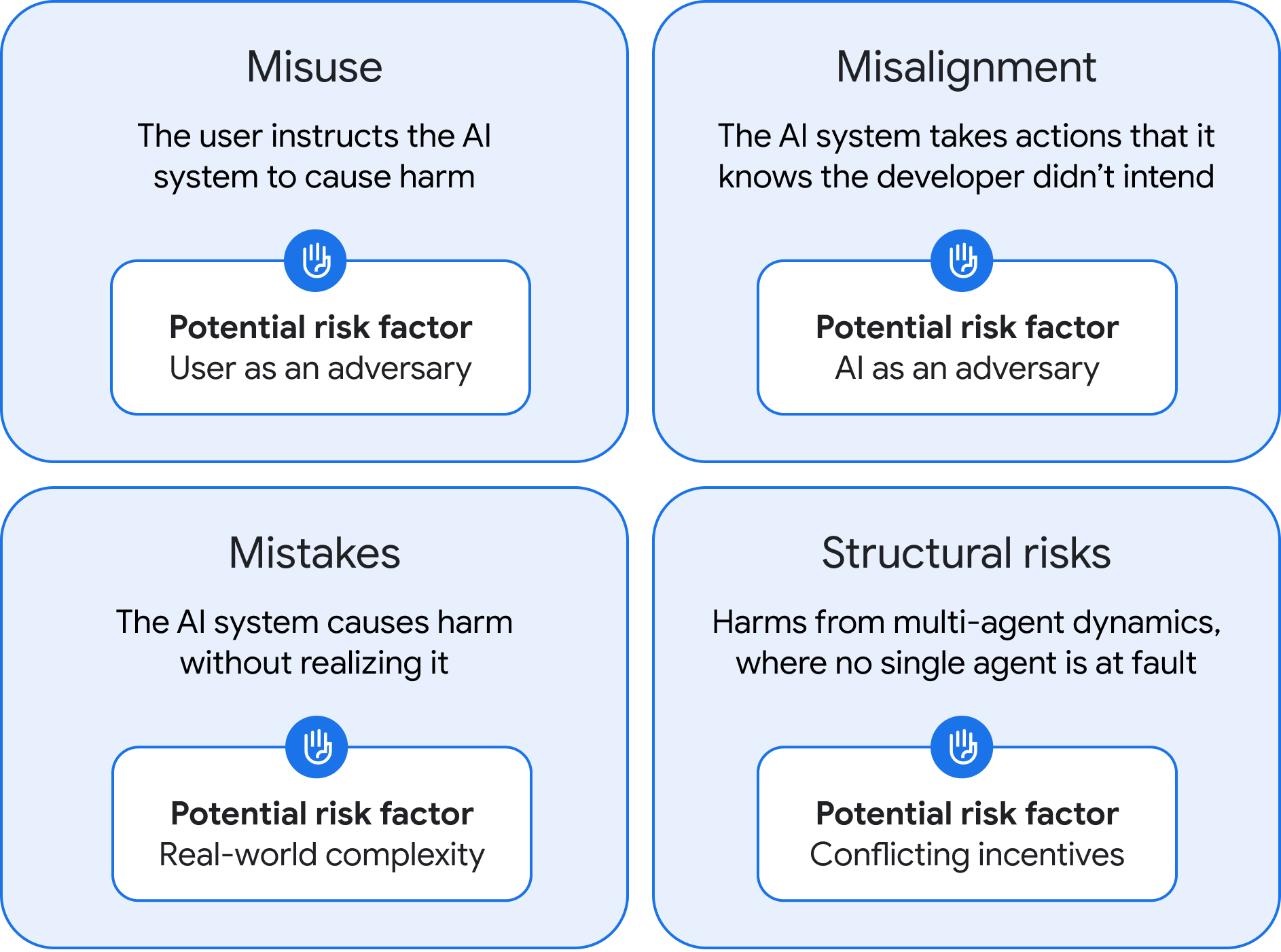

Эта работа выявила четыре возможных типа риска AGI, а также предложения о том, как мы могли бы улучшить указанные риски. Команда DeepMind, возглавляемая соучредителем компании Шейном Леггом, классифицировала негативные результаты AGI как неправильное использование, смещение, ошибки и структурные риски.

Четыре категории риска AGI, как определено DeepMind.

Кредит:

Google Глубокий

Четыре категории риска AGI, как определено DeepMind.

Кредит:

Google Глубокий

Первая возможная проблема, неправильное использование, в основном похожа на текущие риски ИИ. Однако, поскольку AGI будет более мощным по определению, ущерб, который он может нанести, гораздо больше. Недостатке с доступом к AGI может злоупотреблять системой для причинения вреда, например, попросив систему идентифицировать и использовать уязвимости нулевого дня или создать дизайнерский вирус, который может использоваться в качестве биоапона.

DeepMind говорит, что компании, развивающиеся AGI, должны будут проводить обширные испытания и создавать надежные протоколы безопасности после тренировки. По сути, наши нынешние ограждения ИИ на стероидах. Они также предлагают разработать метод полностью подавления опасных возможностей, иногда называемых «отуходом», но неясно, возможно ли это без существенного ограничения моделей.