В настоящее время в сфере ИИ ведется много разработок, но многие из них ведутся в направлениях, которые не интересуют обычных потребителей. Однако многое из того, что Arm делает в этой сфере прямо сейчас, является одними из самых интересных разработок, которые потребители должен заботиться о том, что это было разработано таким образом, чтобы защитить конфиденциальность и быть полезным.

Мы встретились с Ронаном Нотоном, директором по управлению продуктами компании Arm, отвечающим за разработку рабочих нагрузок ИИ на ЦП, чтобы обсудить некоторые из работ, проделанных компанией Arm за последние пару лет.

Это кроссплатформенно

Все благодаря Клейди

Источник: Арм

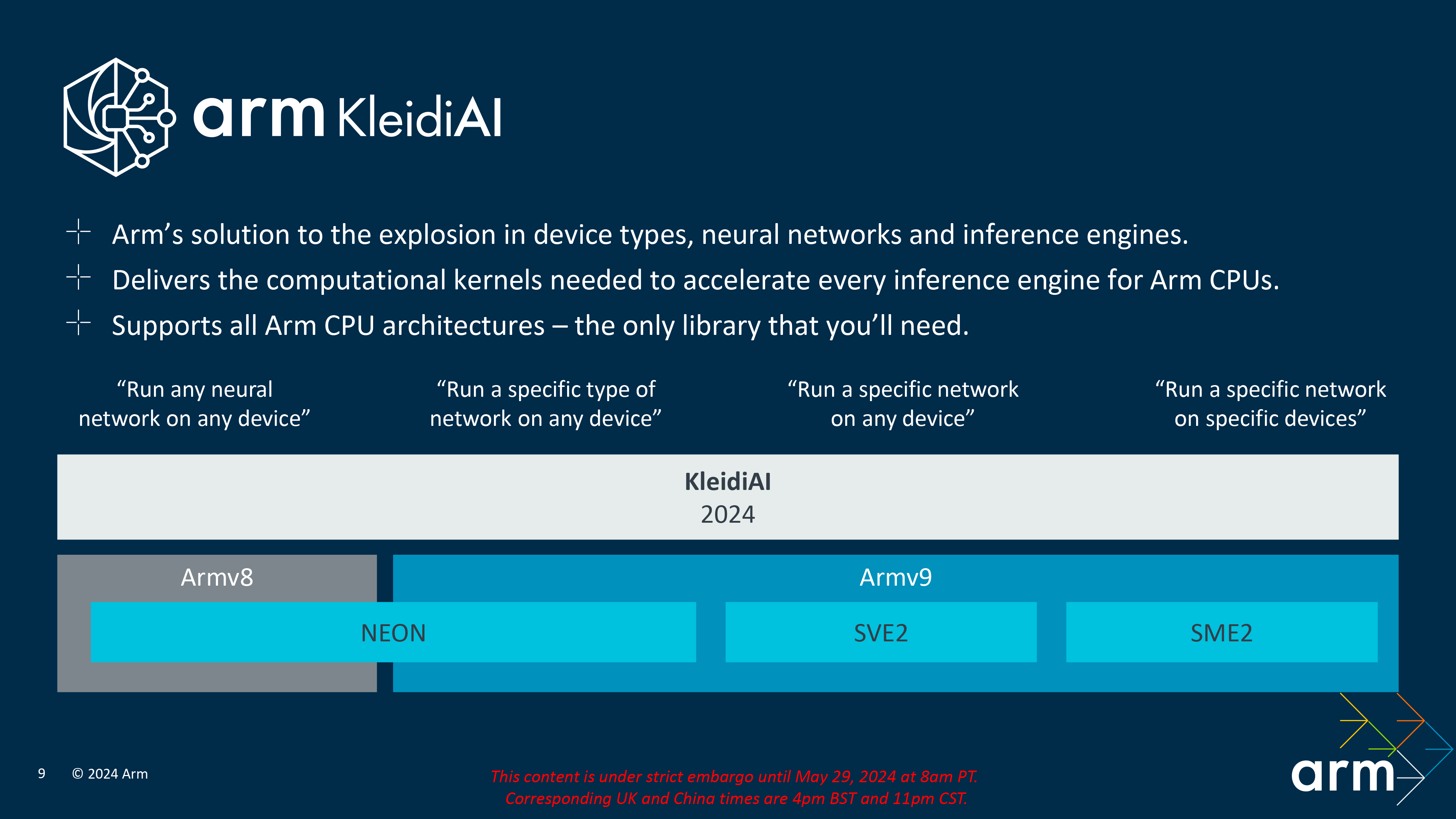

Arm впервые представила свой фреймворк Kleidi AI ранее в этом году вместе с пакетом Compute SubSystems (CSS). Arm хочет вывести ИИ на максимально широкий рынок, и достижение этой цели означает возможность вывести ИИ на максимально возможное количество устройств. Вот почему Arm хочет запускать рабочие нагрузки ИИ на CPU, а не на GPU или NPU, как это делает остальная часть отрасли.

На первый взгляд это может показаться странным, но в этом есть большой смысл. Arm хочет, чтобы разработчики могли «разработать один раз, протестировать один раз, развернуть везде», и запуск на CPU позволяет это сделать. В противном случае разработчикам нужно учитывать особые различия между NPU, которые все разрабатываются по-разному, и GPU, которые все разрабатываются по-разному.

Нотон также рассказал мне, что разработка с Kleidi позволяет разработчикам развертывать на Windows, Android, Linux, где угодно, поскольку сами библиотеки в основном написаны на ассемблере с простыми вызовами C/C++ для использования библиотеки. Это означает, что Kleidi будет работать практически где угодно, и это также означает, что накладных расходов очень мало. В этом смысле это немного похоже на то, как LM Studio позволяет вам загружать и запускать модель практически везде.

Он ориентирован на практические варианты использования.

Возможности, которые вы действительно можете использовать

Источник: Арм

Arm продемонстрировала три демоверсии, и все три из них — это то, что потребители могут на самом деле неважно. Первый вариант наименее полезен, на мой взгляд, и это чат-бот, работающий локально. Мы все это уже видели, и MLC Chat — это быстрый и простой способ локального развертывания LLM на вашем смартфоне. В этом видео Arm продемонстрировала, как Llama2-7B можно развернуть на существующем телефоне Android с использованием 3 ядер процессора серии Arm Cortex-A700 со скоростью генерации токенов 9,6 токенов в секунду. Меньшие модели еще быстрее.

Однако все становится еще лучше и интереснее очень быстро. Если вас не интересуют локальные чат-боты, модель Whisper от OpenAI также может быть развернута локально для расшифровки голосовых сообщений, которые получает пользователь. Затем чат-бот может суммировать расшифровку в пункты, так что если вы не можете прослушать голосовое сообщение, вы можете увидеть, что было сказано, и все равно иметь возможность ответить. LLM галлюцинируют, но расшифровка легко доступна, поэтому вы можете проверить на вменяемость что угодно в голосовом сообщении по расшифровке, если вам это нужно.

Наконец, была также продемонстрирована функция, которая могла бы суммировать групповой чат. Вас когда-нибудь добавляли в групповой чат, и вы видели его только через несколько часов после отправки нескольких сотен сообщений? Идея заключается в том, что вы можете попросить LLM суммировать все, что произошло для вас, чтобы вы могли получить все основные моменты информации. Оттуда вы можете получить быстрое представление о том, о чем идет речь в групповом чате, и вы можете быстро спросить других участников, верна ли информация.

Мощь чат-бота и помощника на устройстве фантастична, когда они объединены с голосовым помощником. «Я имею в виду, вы знаете, речь — это 10, 12 токенов в секунду, верно? Так что если это голосовой помощник, вы знаете, вам не нужно получать 60 или 70 токенов в секунду, что означает, что голосовой помощник очень, очень портативен для многих, многих уровней устройств», — говорит мне Нотон.

Этот акцент на практичности распространяется на то, как Arm думает о развертывании этих моделей на этих многочисленных уровнях устройств. «Так что вы можете сделать вывод на устройстве, где оно берет статические данные или, если вам нужны данные в реальном времени. Допустим, какая столица Франции? Это Париж. Можете ли вы назвать там достопримечательность? О, это Эйфелева башня, верно? Это все происходит на устройстве. Какая там сейчас температура? Это данные в реальном времени». Гармония облачных моделей и моделей на устройстве — это будущее ИИ, и она уже происходит с такими, как Copilot+, Samsung ИИ и Apple Intelligence.

Хорошая производительность и простота использования имеют первостепенное значение

Разработчикам не нужно идти на компромисс

Нотон объяснил мне, что одна из самых больших проблем, когда дело доходит до потребления энергии LLM на устройстве, на самом деле не вычисления, а мощность или пропускная способность DRAM. «Ограничение не обязательно вычислительная мощность. Это мощность DRAM или пропускная способность DRAM», — говорит он мне, и именно поэтому он может работать на старых устройствах, а не только на самых лучших из лучших. Да, будет предел тому, на что способны эти устройства, но предел обнаруживается в DRAM раньше, чем в мощности ЦП.

“А [7B large language model] «занимает 3,5 гигабайта оперативной памяти, и извлечение всех этих данных из DRAM для вывода, для кодирования может занять много энергии. Вот почему мы видим тенденцию к большему количеству моделей с тремя миллиардами, двумя миллиардами и даже одним миллиардом параметров, поскольку модели становятся меньше, и поскольку точность продолжает улучшаться, потребление энергии будет снижаться, потому что вы извлекаете меньше данных из DRAM», — отмечает он. Другими словами, производительность на самом деле не является проблемой, поскольку модели улучшаются.

Однако разработчикам также будет легко использовать Kleidi, что означает, что они с большей вероятностью будут реализовывать модели на устройстве. «Мы сделали [Kleidi AI] такой легкий и хорошо закодированный, хорошо документированный, хорошая интеграция и руководства. И чтобы его можно было подключить к любой структуре и сделать прозрачным для разработчика приложения. Разработчику приложения не нужно знать об этом.”

Наконец, Нотон также рассказал мне, что они создают Kleidi AI для классического МО, а не только для генеративного ИИ и LLM, так что даже если вы не заинтересованы в генеративном ИИ, все равно есть преимущества, которые вы сможете получить в будущем. Arm уже работает с Google а также для переноса Kleidi на устройства, поскольку Kleidi теперь поддерживается GoogleБиблиотека XNNPACK. XNNPACK — это библиотека, которая ускоряет операции вывода на процессорах Arm, а также поддерживает WebAssembly и x86.