Быстрые ссылки

- Как запустить Llama 2 на Mac или Linux с помощью Ollama

- Как запустить Llama 2 в Windows с помощью веб-интерфейса

Если вам нравится идея ChatGPT, Google Bard, Bing Chat или любой другой ИИ-помощник, тогда у вас могут возникнуть некоторые проблемы, связанные с конфиденциальностью, затратами и т. д. Вот тут-то и появляется Llama 2. Llama 2 — это модель большого языка с открытым исходным кодом, разработанная Meta, и существуют варианты с числом параметров от 7 до 70 миллиардов.

Учитывая, что это LLM с открытым исходным кодом, вы можете модифицировать его и запускать любым способом на любом устройстве. Если вы хотите попробовать его на компьютере с Linux, Mac или Windows, вы можете легко!

Требования

Для локального запуска Llama 2 вам понадобится следующее:

Как запустить Llama 2 на Mac или Linux с помощью Ollama

Если у вас Mac, вы можете использовать Ollama для запуска Llama 2. Это, безусловно, самый простой способ сделать это из всех платформ, поскольку для этого требуется минимум усилий. Все, что вам нужно, это Mac и время для загрузки LLM, поскольку это большой файл.

Шаг 1. Загрузите Олламу

Первое, что вам нужно сделать, это скачать Олламу. Он работает на Mac и Linux и позволяет легко загружать и запускать несколько моделей, включая Llama 2. Вы даже можете запустить его в контейнере Docker, если хотите, с ускорением графического процессора, если вы хотите, чтобы его было легко настроить.

После загрузки Олламы извлеките его в папку по вашему выбору и запустить его.

Шаг 2. Загрузите модель Llama 2.

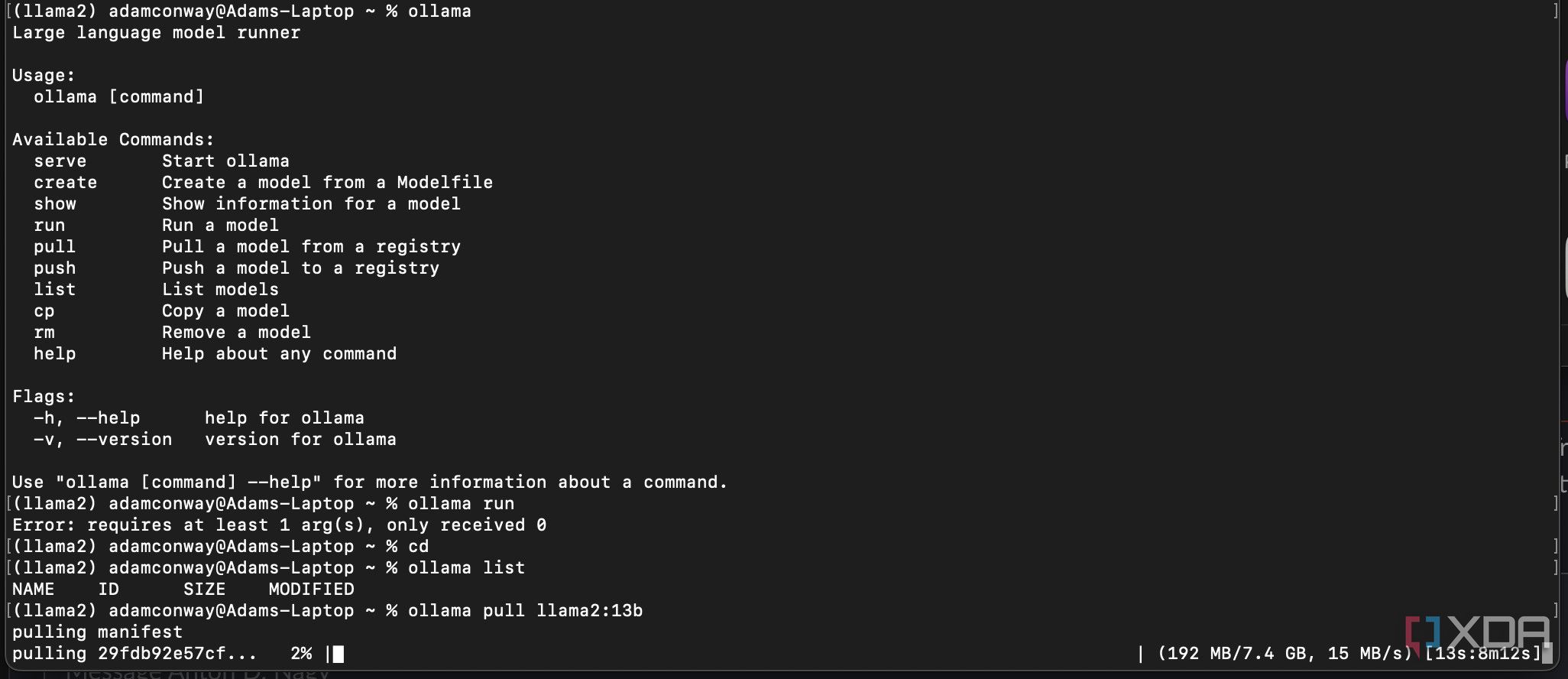

После установки Олламы выполните следующую команду чтобы вытащить модель Llama 2 с 13 миллиардами параметров.

ollama pull llama2:13b

Это может занять некоторое время, поэтому дайте ему время поработать. Размер файла составляет 7,4 ГБ, и при некоторых соединениях он может работать медленно.

Шаг 3. Запустите Llama 2 и взаимодействуйте с ней.

Следующий, выполните следующую команду для запуска и взаимодействия с моделью.

ollama run llama2

После этого модель запустится, и вы сможете с ней взаимодействовать. Все готово!

Как запустить Llama 2 в Windows с помощью веб-интерфейса

Если вы используете компьютер с Windows, вам не о чем беспокоиться, поскольку его так же легко настроить, хотя и требует большего количества шагов! Вы сможете клонировать репозиторий GitHub и запускать его локально, и это все, что вам нужно сделать.

Шаг 1. Загрузите и запустите веб-интерфейс Llama 2.

Если вы знакомы со Stable Diffusion и запускаете его локально через веб-интерфейс, то это, по сути, и есть. Репозиторий GitHub веб-интерфейса oobabooga для генерации текста вдохновлен этим и работает практически таким же образом.

- Скачать репозиторий, указанный выше

- Бегать start_windows.bat, start_linux.shили start_macos.sh в зависимости от того, какую платформу вы используете

- Выберите свой графический процессор и позвольте ему установить все, что ему нужно

Шаг 2. Доступ к веб-интерфейсу Llama 2.

Из вышеизложенного вы можете видеть, что вам будет предоставлен локальный IP-адрес для подключения к веб-интерфейсу. Подключитесь к нему в браузере, и вы увидите веб-интерфейс. Щелкните вокруг и ознакомьтесь с пользовательским интерфейсом. Сначала вы загрузите окно чата, но оно не будет работать, пока вы не загрузите модель.

Шаг 3. Загрузите модель Llama 2.

Теперь вам нужно загрузить модель. Это займет некоторое время, поскольку его необходимо будет загрузить, но вы можете сделать это из веб-интерфейса.

- Нажмите кнопку Модель вкладка вверху

- Справа введите TheBloke/Llama-2-13B-chat-GPTQ и нажмите Скачать

- Если идет загрузка, вы должны увидеть индикатор выполнения в командной строке по мере загрузки соответствующих файлов.

- По завершении обновите список моделей слева и щелкните загруженную модель.

- Нажмите Нагрузкаубедившись, что загрузчик модели говорит GPTQ-для-LLaMa

Загрузка может занять некоторое время, поскольку этим моделям требуется много видеопамяти.

Шаг 4: Взаимодействуйте с Ламой 2!

Все идет хорошо, теперь на вашем компьютере должна быть запущена Llama 2! Вы можете взаимодействовать с ним через браузер в среде без Интернета, если у вас есть оборудование, необходимое для его выполнения. На моем RTX 4080 с 16 ГБ видеопамяти он может генерировать почти 20 токенов в секунду, что значительно быстрее, чем вы найдете в большинстве бесплатных планов для любых LLM, таких как ChatGPT или других.