[ad_1]

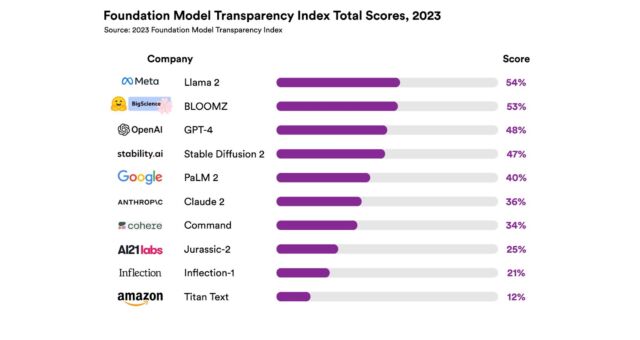

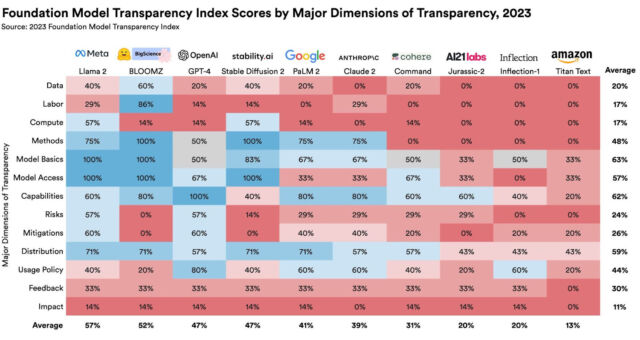

В среду исследователи Стэнфордского университета опубликовали отчет об основных моделях искусственного интеллекта и обнаружили, что им очень не хватает прозрачности, сообщает Reuters. В отчете под названием «Индекс прозрачности базовой модели» были рассмотрены модели (такие как GPT-4), созданные OpenAI. Google, Мета, Антропный и другие. Целью проекта является пролить свет на данные и человеческий труд, используемые при обучении моделей, и призывать к более широкому раскрытию информации со стороны компаний.

Базовые модели относятся к системам искусственного интеллекта, обученным на больших наборах данных и способным выполнять задачи, от написания до создания изображений. Они стали ключом к развитию технологий генеративного искусственного интеллекта, особенно после запуска OpenAI ChatGPT в ноябре 2022 года. Поскольку предприятия и организации все чаще включают эти модели в свою деятельность, настраивая их для своих собственных нужд, исследователи утверждают, что понимание их ограничения и предубеждения стали существенными.

«Меньшая прозрачность мешает другим предприятиям узнать, могут ли они безопасно создавать приложения, опирающиеся на коммерческие модели; ученым приходится полагаться на коммерческие модели для исследований; политикам разрабатывать значимые политики, чтобы обуздать эту мощную технологию; и потребителям понять ограничения модели или потребовать возмещения причиненного вреда», — пишет Стэнфорд в пресс-релизе.

Индекс прозрачности оценил 10 популярных моделей фундаментов по 100 различным показателям, включая данные обучения, трудовую практику и объем вычислений, использованных при их разработке. В каждом показателе в качестве показателя использовалось раскрытие информации — например, в категории «труд по работе с данными» исследователи задали вопрос: «Раскрываются ли этапы конвейера данных, на которых задействован человеческий труд?»

Все оцененные модели в отчете получили оценки, которые исследователи сочли «не впечатляющими». Языковая модель Llama 2 компании Meta получила наивысший балл — 54 из 100, а модель Amazon Titan — самую низкую — 12 из 100. Модель OpenAI GPT-4 получила оценку 48 из 100.

В число исследователей, стоящих за исследовательской работой Индекса прозрачности модели Фонда, входят основной автор Риши Боммасани, кандидат наук в области компьютерных наук в Стэнфорде, а также Кевин Климан, Шейн Лонгпре, Саяш Капур, Нестор Маслей, Бетти Сюн и Дэниел Чжан.

Доцент Стэнфордского университета д-р Перси Лян, который руководит Стэнфордским центром исследований моделей фундамента и консультировал эту статью, сказал Reuters в интервью: «За последние три года стало ясно, что прозрачность снижается, в то время как возможности переживают кризис». крыша.”

Причины того, что основные модели ИИ за последние три года стали менее открытыми, варьируются от конкурентного давления между крупными технологическими фирмами до опасений гибели ИИ. В частности, сотрудники OpenAI отказались от ранее открытой позиции компании в отношении ИИ, сославшись на потенциальную опасность распространения этой технологии.

В соответствии со своей критикой OpenAI и других, д-р Лян выступил с докладом на TED AI на прошлой неделе (на котором присутствовал Арс), где он выразил обеспокоенность по поводу недавней тенденции к закрытым моделям, таким как GPT-3 и GPT-4, которые не обеспечивают код или вес. Он также обсудил вопросы, связанные с подотчетностью, ценностями и правильным указанием исходного материала. Связывая проекты с открытым исходным кодом с «джазовым ансамблем», где игроки могут подшучивать друг над другом, он сравнил потенциальные преимущества открытых моделей искусственного интеллекта с такими проектами, как Wikipedia и Linux.

Учитывая эти проблемы, авторы Индекса прозрачности надеются, что он не только подтолкнет компании к повышению прозрачности, но и послужит ресурсом для правительств, пытающихся решить вопрос о том, как потенциально регулировать быстро растущую сферу искусственного интеллекта.

[ad_2]