Первой компанией, предложившей GPU, стала Nvidia в 2022 году, годом позже к ней присоединилась AMD, а теперь и Intel. Разумеется, я говорю о генерации кадров, и хотя ни одна из этих систем не является идеальной, все они имеют одну и ту же проблему: повышенную задержку ввода. Однако исследователи из Intel разработали алгоритм генерации кадров, который вообще не добавляет задержек, потому что это экстраполяция кадров.

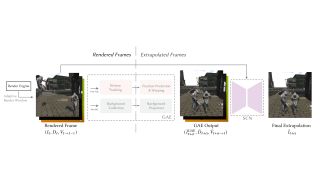

Если у Вас есть склонность к техническим документам, Вы можете прочитать все подробности о том, как все это работает, на GitHub одного из исследователей. Как и у всех технологий рендеринга, у этой есть запоминающееся название и подходящая инициализация: G-buffer Free Frame Extrapolation (GFFE). Чтобы понять, чем она отличается от DLSS, FSR и XeSS-FG, нужно немного разобраться в том, как работают современные системы генерации кадров.

У AMD, Intel и Nvidia разные алгоритмы, но они используют один и тот же фундаментальный подход: Рендерить два кадра подряд и хранить их оба в VRAM видеокарты, а не выводить на экран.

Затем, вместо рендеринга другого кадра, GPU запускает либо кучу вычислительных шейдеров (как в FSR от AMD), либо нейронные сети искусственного интеллекта (DLSS от Nvidia и XeSS от Intel), чтобы проанализировать два кадра на предмет изменений и движения, а затем создать кадр на основе этой информации. Этот сгенерированный кадр помещается в последовательность между двумя ранее отрендеренными кадрами, после чего они в таком порядке отправляются на монитор для отображения.

Хотя ни одна из трех технологий не создает абсолютно идеальные кадры каждый раз, чаще всего Вы не замечаете их, поскольку они появляются на экране лишь на долю секунды, прежде чем на их место приходит нормально отрендеренный кадр. Однако что можно легко заметить, так это увеличенную задержку ввода.

Игровые движки опрашивают изменения ввода через фиксированные промежутки времени и затем применяют все изменения к следующему кадру, который будет отрисован. К сгенерированным кадрам такая информация не применяется, и поскольку два “обычных” кадра были задержаны для создания “искусственного”, возникает дополнительная задержка между тем, как Вы машете мышью и видите движение на экране.

Теоретически это означает, что GFFE может применяться на уровне драйвера, а не требовать интеграции в конвейер рендеринга игры. И что самое приятное, поскольку ни один кадр не задерживается, задержки ввода практически нет.

Здесь рамка экстраполяция вступает в игру. Вместо того, чтобы хранить отрисованные кадры в очереди, алгоритм просто хранит историю того, какие кадры были отрисованы ранее, и использует их для создания нового. Затем система просто добавляет экстраполированный кадр после “обычного”, обеспечивая необходимый прирост производительности.

Подобные системы не новы, они разрабатываются уже много лет, но до сих пор не появилось ничего, что могло бы сравниться с DLSS по скорости работы в реальном времени. Отличительной особенностью GFFE является то, что она довольно быстрая (6,6 миллисекунд на создание кадра 1080p) и не требует доступа к буферам движения или векторов движка рендеринга, только полные кадры.

При генерации кадров, интерполированных или экстраполированных, всегда будут возникать некоторые проблемы, потому что кадры, созданные ИИ, никогда не будут иметь точных входных изменений, только оценочные. Поэтому такие кадры всегда будут казаться немного “неправильными”, но, как уже говорилось, они существуют так мимолетно, что Вы вряд ли заметите это.

Экстраполяция кадров – это естественная эволюция для DLSS, FSR и XeSS, и эта работа Intel и Калифорнийского университета показывает, что мы, вероятно, не за горами до того, чтобы увидеть ее в природе. Поскольку все три компании, производящие графические процессоры, находятся на пороге выпуска новых чипов (Intel уже анонсировала Battlemage), я подозреваю, что к ним присоединятся или быстро последуют DLSS и FSR, использующие ИИ для экстраполяции движения и новых кадров.

Мы все хотим, чтобы графические процессоры следующего поколения имели больше шейдеров, кэша и пропускной способности для игр, но, вероятно, мы приближаемся к некоторому плато в этом отношении. Графические карты ближайшего будущего будут все больше использовать нейронные сети для повышения уровня и поколения, для улучшения производительности. Однако если Вы не можете сказать, что они используются, то, наверное, не имеет значения, как создаются эти пиксели.