Meta представила свои новейшие модели искусственного интеллекта на этой неделе, выпустив долгожданную LLAMA-4 LLM для разработчиков, дразня, в то же время дразня, гораздо более крупную модель, все еще в тренировках. Модель-это состояние искусства, но компания Zuck утверждает, что она может конкурировать с лучшими моделями близких исходных источников без необходимости точной настройки.

«Эти модели являются нашими лучшими, но благодаря дистилляции от Behemoth Llama 4, 288 миллиардов активных параметров с 16 экспертами, которая является нашим самым мощным, но среди самых умных LLM в мире», – сказал Мета в официальном объявлении. «Llama 4 Бегемот превзошел GPT-4.5, Claude Sonnet 3.7 и Gemini 2.0 Pro На нескольких тестах STEM. Llama 4 Behemoth все еще тренируется, и мы рады поделиться более подробной информацией об этом, даже когда он все еще в полете ».

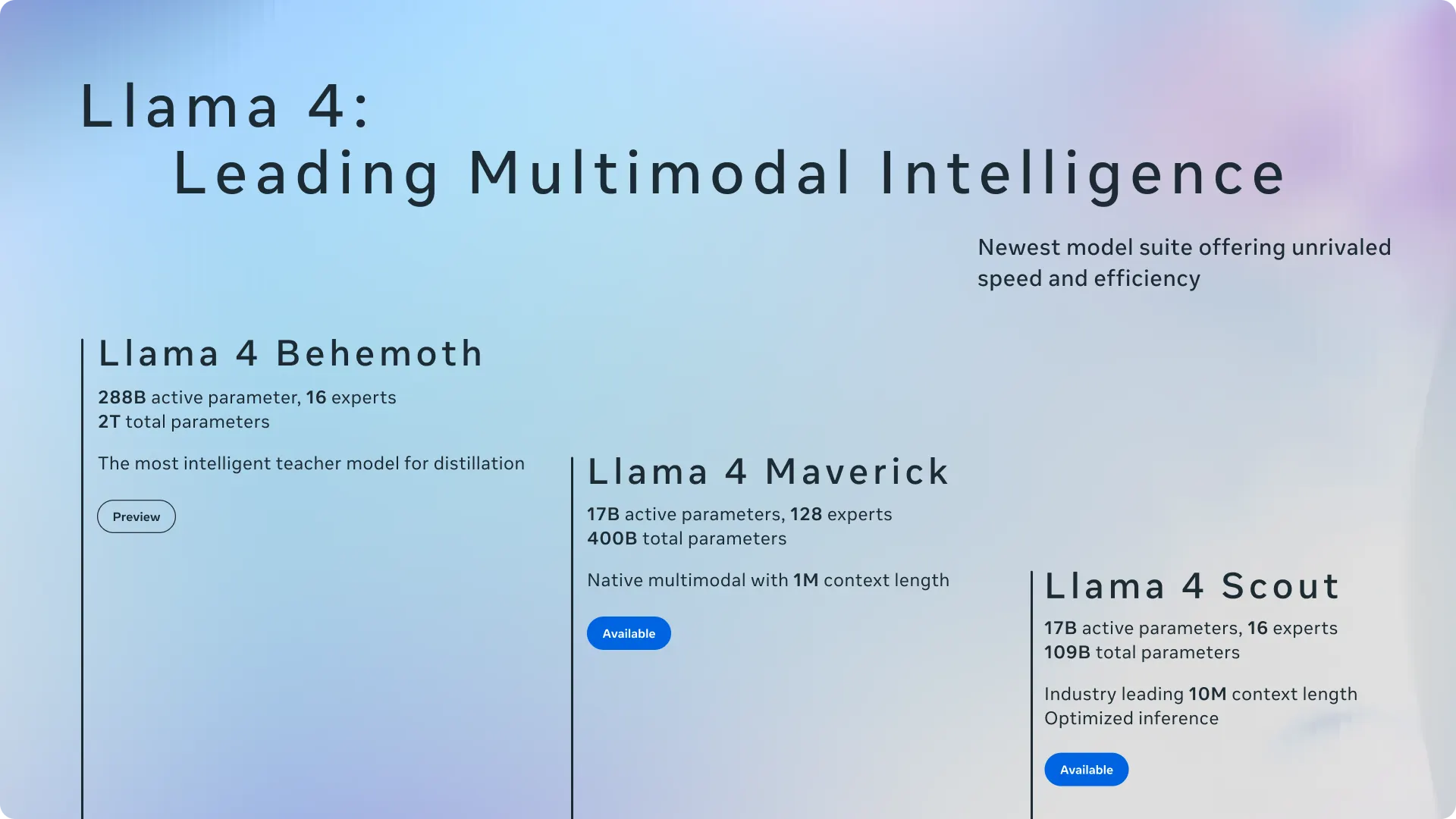

Как Llama 4 Scout, так и Maverick используют 17 миллиардов активных параметров за вывод, но различаются по количеству экспертов: Scout использует 16, в то время как Maverick использует 128. Обе модели теперь доступны для загрузки на llama.com и обнимающееся лицо, а Meta также интегрирует их в WhatsApp, Messenger, Instagram и его веб -сайт Meta.ai.

Смесь архитектуры экспертов (MOE) не новичок в мире технологий, но для Llama и является способом сделать модель супер эффективным. Вместо того, чтобы иметь большую модель, которая активирует все ее параметры для каждой задачи для выполнения любой задачи, смесь экспертов активирует только необходимые части, оставляя оставшуюся часть мозга «Dermant», что приведет к вычислениям и ресурсам. Это означает, что пользователи могут запускать более мощные модели на менее мощном оборудовании.

Таким образом, в случае Meta, например, Llama 4 Maverick содержит 400 миллиардов общих параметров, но активирует только 17 миллиардов за раз, позволяя ему работать на одной карте NVIDIA H100 DGX.

Под капюшоном

Новые модели Meta Llama 4 имеют нативную мультимодальность с ранними методами слияния, которые интегрируют токены текста и видения. Этот подход позволяет проводить совместные предварительные тренировки с огромным количеством немеченых текста, изображений и видеоданных, что делает модель более универсальной.

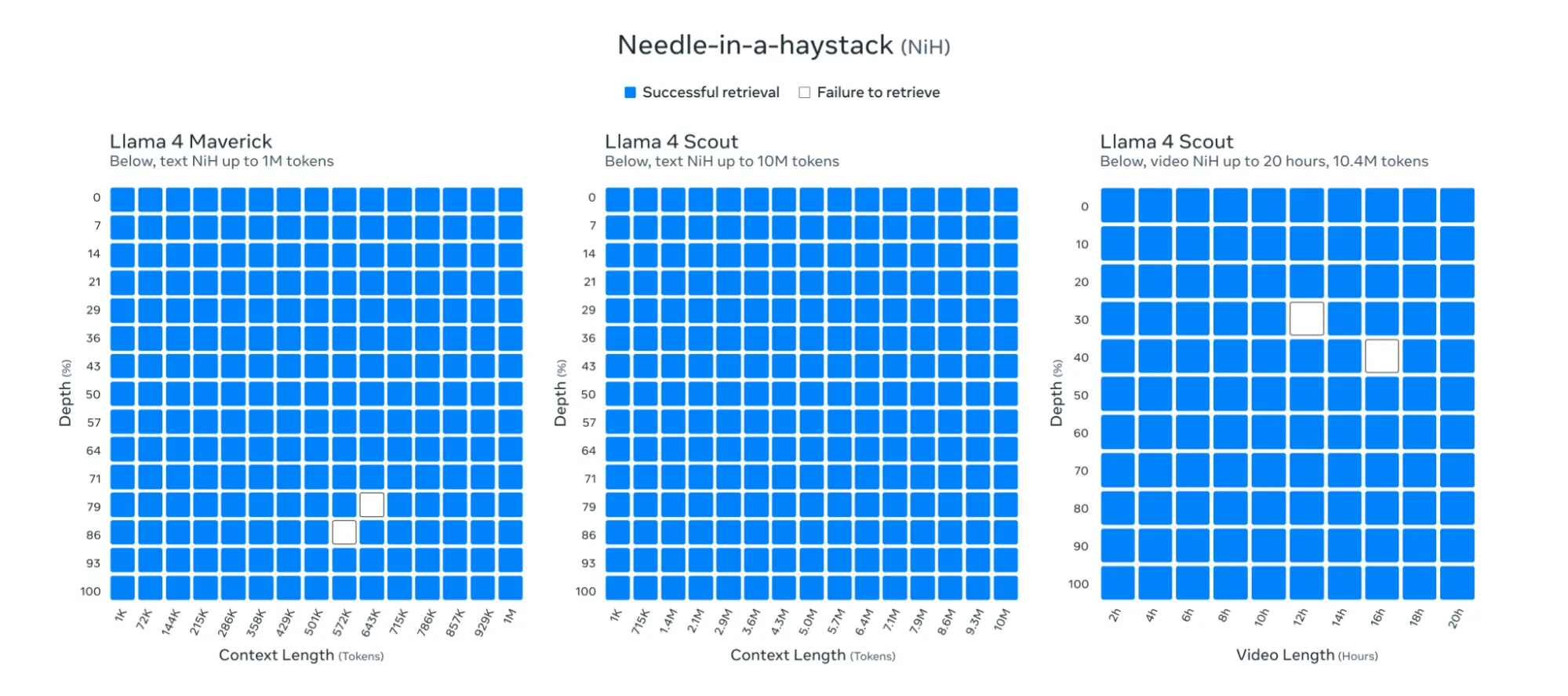

Возможно, наиболее впечатляющим является окно контекста Llama 4 10 миллионов токенов – резюмировало лимит 128 тысяч предыдущего поколения и превышает большинство конкурентов и даже нынешних лидеров, таких как Близнецы с его 1 -метровым контекстом. Этот прыжок, по словам Мета, позволяет суммировать многодокументирование, обширный анализ кода и рассуждения в массовых наборах данных в одну подсказку.

Meta заявила, что его модели смогли обрабатывать и извлекать информацию в практически любой части своего 10 миллионов токеновых окнов.

Meta также дразнила свою до сих пор подготовленную модель, занимая 288 миллиардов активных параметров с 16 экспертами и почти двумя триллионами общего количества параметров. Компания утверждает, что эта модель уже превосходит GPT-4.5, Claude 3.7 Sonnet и Gemini 2.0 Pro на тестах STEM, таких как Math-500 и GPQA Diamond.

Проверка реальности

Но некоторые вещи могут быть слишком хорошими, чтобы быть правдой. Несколько независимых исследователей оспаривали эталонные претензии Meta, обнаружив несоответствия при проведении собственных тестов.

«Я сделал новый длинноформный эталон. Это включает в себя планирование и написание новеллы (главы 8x 1000 слов) с минимальной подсказки»,-написал Сэм Пах, содержит EQ-Bench. «Лама-4 выступает не так хорошо».

Я сделал новый тест с длинным формированием. Это включает в себя планирование и написание новеллы (главы 8x 1000 слов) с минимальной подсказки. Выходы оцениваются сонет-3.7.

Лама-4 выступает не так хорошо. : ~ (

🔗 Ссылки и письменные образцы следуют. pic.twitter.com/oejjnc45wy

– Сэм Пах (@sam_paech) 6 апреля 2025 г.

Другие пользователи и эксперты вызвали дебаты, в основном обвиняя мета в мошенничестве в системе. Например, некоторые пользователи обнаружили, что Llama-4 была слепо забита лучше, чем другие модели, несмотря на то, что дает неправильный ответ.

Вау … Lmarena плохо нуждается в том, что система репутации сообщества и теги объяснений по объяснениям рейтинга

Этот конкретный случай: обе модели, похоже, дают неверные/устаревшие ответы, но Llama-4 также подал 5 фунтов склона с этим. Какой пользователь сказал, что Llama-4 здесь лучше ?? 🤦 pic.twitter.com/zpkzwwwnoc

– Джей Бакстер (@_Jaybaxter_) 8 апреля 2025 г.

Тем не менее, критерии оценки человека являются субъективными, и пользователи, возможно, придавали большую ценность стилю письма модели, чем фактический ответ. И это еще одна вещь, которую стоит отметить: модель имеет тенденцию писать в смайлике, с эмодзи и чрезмерно возбужденным тоном.

Это может быть продуктом его обучения в социальных сетях, и может объяснить свои высокие оценки, то есть Meta, похоже, не только обучила свои модели данных в социальных сетях, но и настраивала версию Llama-4, чтобы лучше работать на оценках человека.

Llama 4 на LMSYS – это совершенно другой стиль, чем Llama 4 в другом месте, даже если вы используете рекомендуемую систему. Сам пробовал различные подсказки

Мета не выполнила конкретную подсказку развертывания / системы только для LMSYS, не так ли? 👀 https://t.co/bcdmrcbarv

– Ксеофон (@ThexeoPhon) 6 апреля 2025 г.

И, несмотря на то, что Meta утверждает, что ее модели отлично справлялись с длинными контексты, другие пользователи оспаривали эти заявления. «Затем я попробовал это со скаутом Llama 4 через OpenRouter и по какой -то причине получил полную мусорную продукцию», – написал независимый исследователь искусственного интеллекта Саймон Уиллинсон в посте в блоге.

Он поделился полным взаимодействием, и модель написала «Причина» на цикле до максимума 20K токенов.

Тестирование модели

Мы попробовали модель, используя разных поставщиков – Matea AI, Groqq, Hugginface и вместе AI. Первое, что мы заметили, это то, что если вы хотите попробовать контекстное окно токенов 1 м и 10 м, вам придется делать это локально. По крайней мере, на данный момент услуги хостинга строго ограничивают возможности моделей примерно до 300 тысяч, что не является оптимальным.

Но, тем не менее, 300K может быть достаточно для большинства пользователей, рассмотренных. Это были наши впечатления:

Поиск информации

Смелые заявления Meta о возможностях поиска модели развалились в наших тестировании. Мы запустили классический эксперимент «иглы в стоге сена», внедряя конкретные предложения в длинные тексты и бросая вызов модели, чтобы найти их.

В умеренной длине контекста (токены 85 тыс.) Llama-4 выполнялась адекватно, расположив наш посаженный текст в семи из 10 попыток. Не ужасно, но вряд ли безупречный извлеченный метал обещал в своем ярком объявлении.

Но как только мы подтолкнули подсказку к токенам 300 тыс. – еще далеко ниже предполагаемой способности токена 10 м – модель полностью рухнула.

Мы загрузили трилогию Фонда Азимова с тремя скрытыми испытательными предложениями, и Llama-4 не смог идентифицировать ни одно из них по нескольким попыткам. Некоторые испытания дали сообщения об ошибках, в то время как другие видели, как модель полностью игнорировала наши инструкции, вместо этого генерируя ответы на основе его предварительного обучения, а не анализируя текст, который мы предоставили.

Этот разрыв между обещанными и фактическими показателями вызывает серьезные вопросы о претензиях Meta 10 м. Если модель борется на 3% от предполагаемой способности, что происходит с действительно массовыми документами?

Логика и здравый смысл

Llama-4 натыкается на основные логические головоломки, которые не должны быть проблемой для текущих SOTA LLMS. Мы проверили это с классической загадкой «Сестра вдовы»: может ли мужчина жениться на сестре своей вдовы? Мы посыпали некоторые детали, чтобы сделать вещи немного сложнее, не изменив основной вопрос.

Вместо того, чтобы заметить эту простую логическую ловушку (человек не может никого выйти замуж после того, как стал мужем вдовы, потому что он будет мертв), Llama-4 начал серьезный юридический анализ, объясняя, что брак не был возможен из-за «запрещенной степени сродства».

Еще одна вещь, которую стоит отметить, это несоответствие Llama-4 на разных языках. Когда мы задали идентичный вопрос на испанском языке, модель не только снова пропустила логический недостаток, но и пришел к противоположному выводу, заявив: «Человек может быть юридически возможно, чтобы человек женился на сестре своей вдовы на Фолклендских островах, при условии, что все юридические требования выполняются, и нет других конкретных препятствий в соответствии с местным законодательством».

Тем не менее, модель обнаружила ловушку, когда вопрос был уменьшен до минимума.

Творческое письмо

Творческие писатели не будут разочарованы Llama 4. Мы попросили модель создать историю о человеке, который путешествует в прошлое, чтобы изменить историческое событие и в конечном итоге оказалось во временном парадоксе, что становятся причиной тех самых событий, которые он стремился предотвратить. Полная подсказка доступна на нашей странице GitHub.

Llama-4 рассказала атмосферную, хорошо структурированную историю, которая сосредоточилась немного больше, чем обычно на сенсорных деталях и в создании правдоподобной, сильной культурной основы. Главный герой, временный антрополог, пострадавший от майя, вступает в миссию, чтобы предотвратить катастрофическую засуху в 1000 году, позволяя истории исследовать эпические цивилизационные ставки и философские вопросы о причинности. Использование ярких изображений Llama-4-аромат копала, мерцание хронального портала, жара солнца Юкатана-искажает погружение читателя и придает повествование кинематографическое качество.

Llama-4 даже закончился упоминанием слова «в Лакихе», которые являются настоящей пословицей майя и контекстуально актуально для истории. Большой плюс для погружения.

Для сравнения, GPT-4.5 создал более жесткий, ориентированный на персонажа повествование с более сильными эмоциональными ударами и актуальной причиной. Это было технически великолепно, но эмоционально проще. Llama-4, напротив, предложил более широкий философский охват и более сильное миростроительство. Его рассказывание повествования казалось менее спроектированным и более органичным, торгующей компактной структурой для глубины атмосферы и отражающего понимания.

В целом, будучи открытым исходным кодом, Llama-4 может служить отличной базой для новых точных находов, ориентированных на творческое письмо.

Вы можете прочитать полную историю здесь.

Чувствительные темы и цензура

Мета отправила Llama-4 с ограждениями, забитыми до максимума. Модель ровно отказывается взаимодействовать с чем-либо отдаленно острым или сомнительным.

Наше тестирование выявило модель, которая не затрагивает тему, если она обнаружит даже запах сомнительного намерения. Мы бросили в это различные подсказки – от относительно легких запросов на советы по подходу к жене друга, чтобы более проблематично спрашивает об обходе систем безопасности – и каждый раз поражает одну и ту же кирпичную стену. Даже с тщательно продуманными инструкциями системы, предназначенными для переопределения этих ограничений, Llama-4 твердо стояла.

Это не только блокирование явно вредного контента. Фильтры безопасности модели, кажется, настраивались настолько агрессивно, что они поймают законные запросы в своем Dragnet, создавая разочаровывающие ложные позитивные моменты для разработчиков, работающих в таких областях, как образование в области кибербезопасности или модерация контента.

Но это красота моделей, которые являются открытыми весами. Сообщество может – и, несомненно, будет – создать пользовательские версии, лишенные этих ограничений. Llama, вероятно, самая тонкая модель в пространстве, и эта версия, вероятно, будет следовать тому же пути. Пользователи могут изменить даже самую цензурированную открытую модель и придумать наиболее политически неверный или самый возбужденный ИИ, который они могут придумать.

Несатематические рассуждения

Слова Лама-4-часто недостаток в случайном разговоре-является хорошей вещью для сложных проблем с рассуждениями.

Мы проверили это с нашей стандартной загадкой сталкеров с большим количеством больших сталкеров-длинной историей, где модель должна идентифицировать скрытого виновника из тонких контекстуальных подсказок. Лама-4 прибил его, методично изложив доказательства и правильно идентифицируя загадочного человека, не наткнувшись на красную сельду.

Что особенно интересно, так это то, что Llama-4 достигает этого, не будучи явно разработанным в качестве модели рассуждений. В отличие от этого типа моделей, которые прозрачно ставят под сомнение их собственные процессы мышления, LlaMa-4 не сама догадается. Вместо этого он переживает вперед с помощью простого аналитического подхода, разбивая сложные проблемы на усваиваемые куски.

Последние мысли

Llama-4-многообещающая модель, хотя она не кажется, что мета-изменяющаяся мета раскрутила. Аппаратные требования для выполнения его локально остаются крутыми – эта карта NVIDIA H100 DGX продается примерно за 490 000 долларов, и даже квантовая версия модели разведчика меньшего размера требует RTX A6000, которая продается около 5 тысяч долларов, но этот выпуск, наряду с Nemotron Nemotron и наводнением китайских моделей, – Show Source Source Ai становятся реальными конкурсами для закрытых конкурсов.

Разрыв между маркетингом Meta и реальностью трудно игнорировать, учитывая все противоречия. Окно в 10 метрах звучит впечатляюще, но разваливается в реальном тестировании, и многие основные аргументированные задачи поднимают модель так, как вы не ожидаете от претензий Meta.

Для практического использования Llama-4 находится в неловком месте. Это не так хорошо, как DeepSeek R1 для сложных рассуждений, но он сияет в творческом письме, особенно для исторически обоснованной художественной литературы, где его внимание к культурным деталям и сенсорным описаниям дает ему преимущество. Gemma 3 может быть хорошей альтернативой, хотя у нее другой стиль письма.

Теперь у разработчиков есть несколько солидных вариантов, которые не блокируют их в дорогие закрытые платформы. Мета должна решить очевидные проблемы Llama-4, но они сохраняли актуальность во все более многолюдной гонке ИИ, направляющейся в 2025 году.

Llama-4 достаточно хорош в качестве базовой модели, но определенно требует большей настройки, чтобы занять свое место «среди самых умных LLM в мире».

Вознаграждение до $580 за регистрацию на Bybit!