Арс Техника

В четверг пара технических любителей выпустила Riffusion, модель искусственного интеллекта, которая генерирует музыку из текстовых подсказок, создавая визуальное представление звука и преобразовывая его в звук для воспроизведения. Он использует доработанную версию модели синтеза изображений Stable Diffusion 1.5, по-новому применяя визуальную скрытую диффузию к обработке звука.

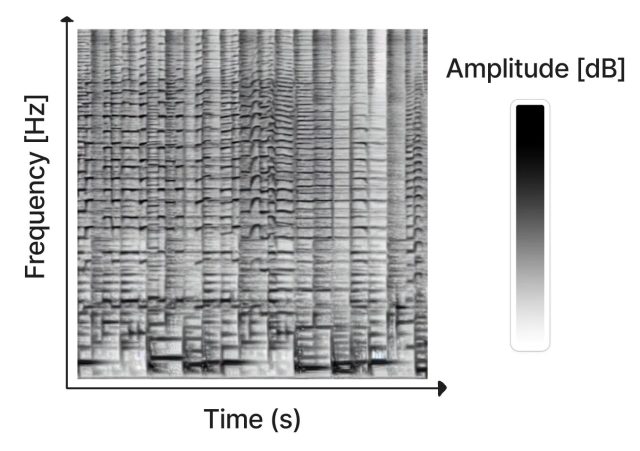

Созданный Сетом Форсгреном и Хайком Мартиросом в качестве хобби, Riffusion работает путем создания сонограмм, которые сохраняют звук в двумерном изображении. На сонограмме ось X представляет время (порядок воспроизведения частот слева направо), а ось Y представляет частоту звуков. При этом цвет каждого пикселя изображения представляет собой амплитуду звука в данный момент времени.

Так как сонограмма — это тип изображения, Stable Diffusion может ее обработать. Форсгрен и Мартирос обучили пользовательскую модель стабильной диффузии с примерами сонограмм, связанных с описаниями звуков или музыкальных жанров, которые они представляли. Обладая этими знаниями, Riffusion может генерировать новую музыку на лету на основе текстовых подсказок, описывающих тип музыки или звука, который вы хотите услышать, например «джаз», «рок» или даже набор текста на клавиатуре.

После создания изображения сонограммы Riffusion использует Torchaudio, чтобы преобразовать сонограмму в звук, воспроизводя ее как звук.

«Это модель Stable Diffusion v1.5 без каких-либо изменений, просто настроенная на изображения спектрограмм в сочетании с текстом», — пишут создатели Riffusion на странице с пояснениями. «Он может генерировать бесконечные варианты подсказок, меняя начальное число. Все те же веб-интерфейсы и методы, такие как img2img, рисование, отрицательные подсказки и интерполяция, работают из коробки».

Посетители веб-сайта Riffusion могут экспериментировать с моделью искусственного интеллекта благодаря интерактивному веб-приложению, которое генерирует интерполированные сонограммы (плавно сшитые вместе для непрерывного воспроизведения) в режиме реального времени, при этом спектрограмма непрерывно визуализируется в левой части страницы.

Он также может объединять стили. Например, ввод фразы «гладкий тропический танцевальный джаз» позволяет использовать элементы разных жанров для получения нового результата, поощряя эксперименты путем смешивания стилей.

Конечно, Riffusion — не первый музыкальный генератор на базе искусственного интеллекта. Ранее в этом году Harmonai выпустила Dance Diffusion, генеративную музыкальную модель на базе искусственного интеллекта. Музыкальный автомат OpenAI, анонсированный в 2020 году, также генерирует новую музыку с помощью нейронной сети. А такие веб-сайты, как Soundraw, создают музыку без остановки на лету.

По сравнению с более упорядоченными музыкальными усилиями ИИ, Riffusion больше похож на хобби-проект. Музыка, которую он генерирует, варьируется от интересной до непонятной, но остается заметным применением технологии скрытой диффузии, которая манипулирует звуком в визуальном пространстве.

Контрольная точка и код модели Riffusion доступны на GitHub.